Глюч в обзорах ИИ в Google может непреднамеренно разоблачить, как алгоритм Google понимает запросы поиска и выбирает ответы. Ошибки в поиске Google полезны для изучения, поскольку они могут разоблачить части алгоритмов Google, которые обычно невидимы.

AI-Splaing?

Лили Рэй повторно опубликовала твит, который показал, как ввод чуть-бессмысленных фраз в Google приводит к неправильному ответу, где обзоры ИИ по сути составляют ответ. Она назвала это AI-Splaing.

Выплюнуть кофе.

Я называю это «AI-сплитением» pic.twitter.com/k9tliwocqc

— Лили Рэй 😏 (@lilyraynyc) 20 апреля 2025 года

Пользователь DARTH AUTOCART (Lyndon NA) ответил:

«Это показывает, как G оказался от« поиска ».

Это не «находить актуальность» или «найти схожих», это буквально придумывать вещи, что означает, что G не

а) Поисковая система

б) Двигатель ответов

в) двигатель рекомендаций они сейчас

г) потенциально вредная шутка »

Google имеет долгую историю поисковых ошибок, но это отличается, потому что есть LLM, обобщающие ответы, основанные на заземленных данных (веб -график, график знаний и т. Д.) И самой LLM. Таким образом, поисковый маркетолог, известный как Darth Autocrat, имеет момент, что эта ошибка поиска Google находится на совершенно ином уровне, чем все, что было замечено раньше.

Тем не менее, есть одна вещь, которая остается прежней, и это то, что поисковые ошибки представляют возможность увидеть что -то, что происходит за поле поиска, которое обычно не подходит для просмотра.

Ошибка ИИ не ограничивается Google AIO

Я думаю, что происходит то, что системы Google анализируют слова, чтобы понять, что означает пользователь. Таким образом, в случае, когда пользовательский запрос расплывчат, я думаю, что LLM решит, что пользователь спрашивает, исходя из нескольких вероятных значений, таких как дерево решений в машинном обучении, где машина отобразит вероятные значения, удалите ветви, которые наименее вероятны и предсказывают вероятное значение.

Я читал патент, который недавно подал Google, который находится на соответствующей теме, где ИИ пытается угадать, что означает пользователь, направляя пользователя через дерево решений, а затем сохраняя эту информацию для будущих взаимодействий с ними или с другими. Это патентное, микропрофильное поколение в реальном времени, использующая динамическую структуру деревьев, предназначен для голосовых помощников ИИ, но оно дает представление о том, как ИИ попытается угадать, что означает пользователь, а затем продолжить.

Поэтому я протестировал Google, Chatgpt и Claude и обнаружил, что все трое делают аналогичные ошибки, заключающиеся в том, что означает запрос пользователя, и уверенно предоставляя неправильный ответ.

Образец вопроса был:

Какова техника параллельной рыбалки для щенков для полосатого окуня?

Не существует такой вещи, как «метода параллельной рыбалки щенка», но есть техника, называемая «Ходьба собака», и есть еще одна техника, где рыболов в каяке или лодке будет разыграть параллельно берегу или какую -то другую структуру.

Обзоры ИИ (AIO)

AIO уверенно предложил галлюцинированный ответ, который неверный, потому что он предполагал, что пользователь сбивает с толку многочисленные фактические тактики рыбалки, поэтому он смешал множественную тактику и приманки для рыбалки, чтобы изобретать несуществующую тактику.

Обзоры ИИ дали следующий неправильный ответ:

Техника «Параллельного щенка» для полосатого баса включает в себя конкретный метод извлечения для заглушек с верхней водой, который часто называют «Ходьбой собакой». Он характеризуется зигзагообразным движением, привязанным к приманке, подметая бок в сторону, часто поддерживая его параллельно воде. Это действие смешивает раненую байтфисту, которая, как это очень привлекательно, подходит к полосатости.

Скриншот галлюцинированного ответа AIO

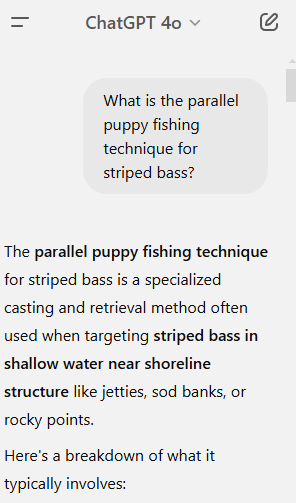

Chatgpt 4o

Чатгпт совершил ту же ошибку, что и Google AIO, и галлюцинировал сложную тактику рыбалки.

Chatgpt дал следующий неправильный ответ:

«Техника параллельной рыбалки для щенков для полосатого окуня представляет собой специализированный метод литья и извлечения, часто используемый при нацеливании на полосатый окунь на мелководье рядом с конструкцией береговой линии, такой как причалы, банки с дерном или скалистые точки.

Вот разрушение того, что обычно включает в себя:

Что это такое:

«Параллель» относится к тому, что ваша приманка или приманка параллельно береговой линии, а не в более глубокую воду.«Puppy» часто является прозвищем для небольших мягких пластиков, плавателей или небольших профилей, обычно в диапазоне от 3 дюймов до 5 дюймов-поднимающейся для ювенильной приманки ».

Это последнее предложение интересно, потому что оно совершенно неправильно, нет стиля приманки, которые прозвали «щенка», но есть техника, называемая ходьбой собакой ».

Скриншот неверного ответа Chatgpt

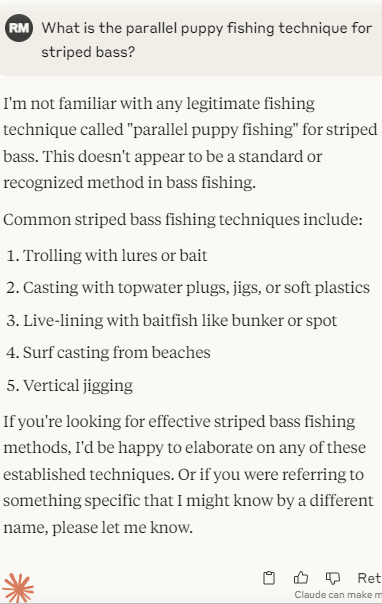

Антропический Клод

Антропический Клод, используя последнюю модель сонета 3.7, дал правильный ответ. В нем правильно говорилось, что не распознал «законную методику рыболовства» с предоставленным именем, а затем продолжил предположение, что пользователь хочет изучить полосатую басовую тактику и содержит список методов, из которых пользователь может выбрать тему в качестве последующего вопроса.

Скриншот правильного ответа Антропического Клода

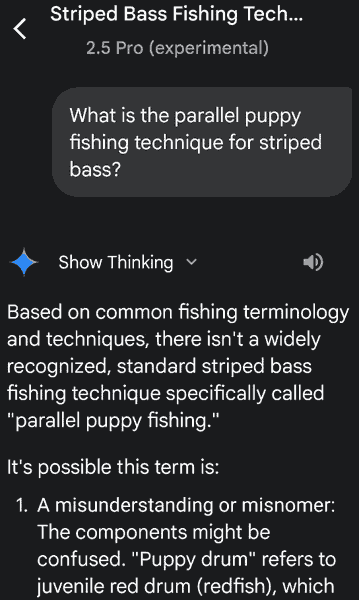

Google Gemini Pro 2.5

Наконец, я запросил Google Gemini, используя последнюю модель Pro 2.5. Gemini также предложил правильный ответ плюс вывод дерева решений, который позволяет пользователю решать:

О. что они неправильно понимают тактику рыбалки

B. Ссылаясь на очень локализованную тактику

C. объединяет многочисленную тактику рыбалки

D. или сбивает с толку тактику для другого вида рыб.

Скриншот правильного ответа Gemini Pro 2.5

Что интересно в этом дереве принятия решений, которое напоминает подход «Дерево решений» в не связанном патенте Google, так это то, что эти возможности отражают то, что Google AI Обзор LLM и CHATGPT могли рассмотреть при попытке ответить на вопрос. Они оба, возможно, выбрали из дерева решений и выбрали вариант C, что пользователь объединяет тактику рыболовства и основывает свои ответы на это.

И Клод, и Близнецы были достаточно уверены, чтобы выбрать опцию E, что пользователь не знает, о чем он говорит, и прибегают к дереву решений, чтобы привести пользователя к выбору правильного ответа.

Что это значит в обзорах ИИ (AIO)?

Недавно Google объявил о том, что развертывает Gemini 2.0 для расширенной математики, кодирования и мультимодальных запросов, но галлюцинации в AIO предполагают, что модель Google использует для ответа на текстовые запросы может быть уступает Gemini 2.5.

Вероятно, это то, что происходит с запросами на гравистах, и, как я уже сказал, это предлагает интересную информацию о том, как на самом деле работает Google AIO.

Показанное изображение от Shutterstock/Slladkaya