Сканирование необходимо для каждого веб-сайта, большого и маленького.

Если ваш контент не сканируется, у вас нет шансов стать видимым на платформах Google.

Давайте поговорим о том, как оптимизировать сканирование, чтобы предоставить вашему контенту должное внимание.

Содержание

- 1 Что такое сканирование в SEO

- 2 Как работает веб-сканирование

- 3 Почему важно, чтобы ваш сайт можно было просканировать

- 4 Измерение сканирования: бюджет сканирования по сравнению с бюджетом сканирования. Эффективность сканирования

- 5 Поддержка поисковых систем для сканирования

- 6 Как добиться эффективного сканирования сайта

- 7 Оптимизируйте веб-сканирование

Что такое сканирование в SEO

В контексте SEO сканирование — это процесс, в котором боты поисковых систем (также известные как поисковые роботы или поисковые роботы) систематически обнаруживают контент на веб-сайте.

Это может быть текст, изображения, видео или другие типы файлов, доступные ботам. Независимо от формата контент можно найти исключительно по ссылкам.

Как работает веб-сканирование

Поисковый робот работает, обнаруживая URL-адреса и загружая содержимое страницы.

Во время этого процесса они могут передать контент в индекс поисковой системы и извлечь ссылки на другие веб-страницы.

Эти найденные ссылки будут относиться к разным категориям:

- Новые URL-адреса которые неизвестны поисковой системе.

- Известные URL-адреса, которые не дают указаний по сканированию будет периодически пересматриваться, чтобы определить, были ли внесены какие-либо изменения в содержание страницы, и поэтому индекс поисковой системы нуждается в обновлении.

- Известные URL-адреса, которые были обновлены и дать четкие указания. Их следует повторно просканировать и переиндексировать, например, с помощью XML-карты сайта с отметкой даты и времени последнего изменения.

- Известные URL-адреса, которые не были обновлены и дать четкие указания. Их нельзя повторно сканировать или переиндексировать, например заголовок ответа HTTP 304 Not Modified.

- Недоступные URL-адреса которые не могут или не должны отслеживаться, например те, которые находятся за формой входа в систему или ссылками, заблокированными тегом robots «nofollow».

- Запрещенные URL-адреса что поисковые роботы не будут сканировать, например, заблокированные файлом robots.txt.

Все разрешенные URL-адреса будут добавлены в список страниц для посещения в будущем, известный как очередь сканирования.

Однако им будет присвоен разный уровень приоритета.

Это зависит не только от классификации ссылок, но и от множества других факторов, определяющих относительную важность каждой страницы в глазах каждой поисковой системы.

Большинство популярных поисковых систем имеют своих собственных ботов, которые используют определенные алгоритмы для определения того, что и когда они сканируют. Это означает, что не все ползают одинаково.

Googlebot ведет себя иначе, чем Bingbot, DuckDuckBot, Yandex Bot или Yahoo Slurp.

Почему важно, чтобы ваш сайт можно было просканировать

Если страница на сайте не просканирована, она не будет ранжироваться в результатах поиска, так как маловероятно, что она будет проиндексирована.

Но причины, по которым ползание имеет решающее значение, гораздо глубже.

Быстрое сканирование необходимо для контента, ограниченного по времени.

Часто, если его не просканировать и быстро не показать, он становится неактуальным для пользователей.

Например, аудиторию не будут интересовать последние новости прошлой недели, прошедшее событие или продукт, который уже распродан.

Но даже если вы не работаете в отрасли, где время выхода на рынок имеет решающее значение, быстрое сканирование всегда полезно.

Когда вы обновляете статью или публикуете значительное изменение SEO на странице, чем быстрее Googlebot сканирует ее, тем быстрее вы получите выгоду от оптимизации — или увидите свою ошибку и сможете исправить ее.

Вы не можете быстро потерпеть неудачу, если Googlebot сканирует медленно.

Считайте сканирование краеугольным камнем SEO; ваша органическая видимость полностью зависит от того, насколько хорошо это сделано на вашем сайте.

Измерение сканирования: бюджет сканирования по сравнению с бюджетом сканирования. Эффективность сканирования

Вопреки распространенному мнению, Google не стремится сканировать и индексировать весь контент всех веб-сайтов в Интернете.

Сканирование страницы не гарантируется. На самом деле, на большинстве сайтов значительная часть страниц никогда не сканировалась роботом Googlebot.

Если вы видите исключение «Обнаружено — в настоящее время не проиндексировано» в отчете об индексации страниц Google Search Console, эта проблема касается вас.

Но если вы не видите этого исключения, это не обязательно означает, что у вас нет проблем со сканированием.

Существует распространенное заблуждение о том, какие показатели имеют значение при измерении сканирования.

Ошибка краулингового бюджета

SEO-специалисты часто ищут краулинговый бюджеткоторый относится к количеству URL-адресов, которые робот Googlebot может и хочет сканировать в течение определенного периода времени для определенного веб-сайта.

Эта концепция подталкивает к максимальному сканированию. Это дополнительно подкрепляется отчетом о статусе сканирования Google Search Console, показывающим общее количество запросов на сканирование.

Но идея о том, что чем больше ползать, тем лучше, совершенно ошибочна. Общее количество сканирований — не что иное, как метрика тщеславия.

Заманчивое 10-кратное количество сканирований в день не обязательно коррелирует с более быстрой (повторной) индексацией интересующего вас контента. Все, с чем это коррелирует, — это дополнительная нагрузка на ваши серверы, что стоит вам больше денег.

Никогда не следует сосредотачиваться на увеличении общего объема сканирования, а скорее на качественном сканировании, которое приводит к ценности SEO.

Значение эффективности сканирования

Качественное сканирование означает сокращение времени между публикацией или внесением существенных обновлений на релевантной для SEO страницы и следующим посещением ее роботом Googlebot. Эта задержка является эффективность сканирования.

Чтобы определить эффективность сканирования, рекомендуется извлечь созданное или обновленное значение даты и времени из базы данных и сравнить его с отметкой времени следующего сканирования URL-адреса роботом Googlebot в файлах журнала сервера.

Если это невозможно, вы можете рассчитать его, используя дату последнего изменения в картах сайта XML, и периодически запрашивать соответствующие URL-адреса с помощью API проверки URL-адресов Search Console, пока он не вернет статус последнего сканирования.

Количественно определяя временную задержку между публикацией и сканированием, вы можете измерить реальное влияние оптимизации сканирования с помощью важной метрики.

По мере снижения эффективности сканирования вашей аудитории на поверхностях Google будет показываться новый или обновленный контент, релевантный поисковой оптимизации.

Если оценка эффективности сканирования вашего сайта показывает, что роботу Googlebot требуется слишком много времени для посещения важного контента, что вы можете сделать для оптимизации сканирования?

Поддержка поисковых систем для сканирования

В последние несколько лет было много разговоров о том, что поисковые системы и их партнеры сосредоточены на улучшении сканирования.

Ведь это в их интересах. Более эффективное сканирование не только дает им доступ к лучшему контенту для повышения их результатов, но также помогает мировой экосистеме, уменьшая выбросы парниковых газов.

Больше всего разговоров было о двух API, предназначенных для оптимизации сканирования.

Идея заключается в том, что поисковые роботы не решают, что сканировать, а веб-сайты могут передавать соответствующие URL-адреса непосредственно поисковым системам через API для запуска сканирования.

Теоретически это не только позволяет вам быстрее индексировать ваш последний контент, но также дает возможность эффективно удалять старые URL-адреса, что в настоящее время не очень хорошо поддерживается поисковыми системами.

Поддержка не Google от IndexNow

Первый API ИндексСейчас. Это поддерживается Bing, Yandex и Seznam, но не Google. Он также интегрирован во многие инструменты SEO, CRM и CDN, что потенциально снижает усилия по разработке, необходимые для использования IndexNow.

Это может показаться быстрой победой для SEO, но будьте осторожны.

Использует ли значительная часть вашей целевой аудитории поисковые системы, поддерживаемые IndexNow? В противном случае запуск сканирования их ботами может иметь ограниченную ценность.

Но что еще более важно, оцените, как интеграция с IndexNow влияет на вес сервера по сравнению с улучшением показателя эффективности сканирования для этих поисковых систем. Может случиться так, что затраты не стоят выгоды.

Поддержка Google из API индексирования

Второй — это API индексирования Google. Google неоднократно заявлял, что API можно использовать только для сканирования страниц с разметкой объявлений о вакансиях или трансляций событий. И многие проверили это и доказали, что это утверждение ложно.

Отправляя несоответствующие URL-адреса в Google Indexing API, вы увидите значительное увеличение сканирования. Но это прекрасный пример того, почему «оптимизация краулингового бюджета» и принятие решений на основе объема краулинга — это неправильное понимание.

Поскольку для несовместимых URL-адресов отправка не влияет на индексацию. И когда вы перестаете думать об этом, это обретает смысл.

Вы отправляете только URL. Google быстро просканирует страницу, чтобы увидеть, есть ли на ней указанные структурированные данные.

Если да, то это ускорит индексацию. Если нет, то не будет. Гугл проигнорирует.

Таким образом, вызов API для несовместимых страниц ничего не дает, кроме добавления ненужной нагрузки на ваш сервер и бесполезной траты ресурсов разработки.

Поддержка Google в консоли поиска Google

Другой способ, которым Google поддерживает сканирование, это отправка вручную в Google Search Console.

Большинство URL-адресов, отправленных таким образом, будут просканированы, и их статус индексации изменится в течение часа. Но существует ограничение в 10 URL-адресов в течение 24 часов, поэтому очевидная проблема с этой тактикой заключается в масштабе.

Однако это не означает пренебрежение ею.

Вы можете автоматизировать отправку URL-адресов, которые вы считаете приоритетными, с помощью сценариев, которые имитируют действия пользователя, чтобы ускорить сканирование и индексацию для избранных.

Наконец, для тех, кто надеется, что нажатие кнопки «Подтвердить исправление» на «обнаруженных в настоящее время не проиндексированных» исключениях вызовет сканирование, в моем тестировании на сегодняшний день это не помогло ускорить сканирование.

Итак, если поисковые системы не будут нам существенно помогать, как мы можем помочь себе?

Как добиться эффективного сканирования сайта

Есть пять тактик, которые могут повлиять на эффективность сканирования.

1. Обеспечьте быстрый и правильный ответ сервера

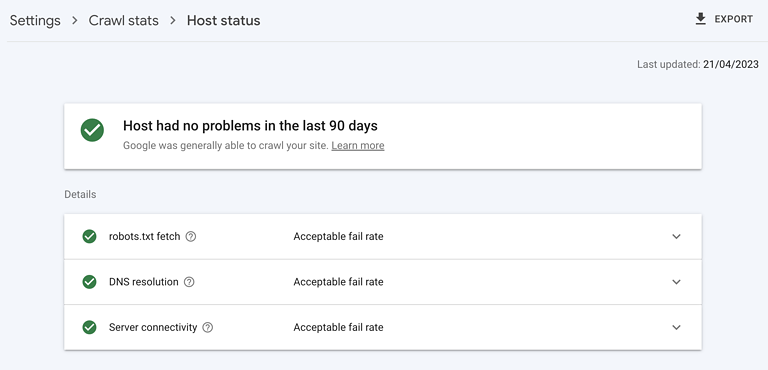

Скриншот из Google Search Console, май 2023 г.

Скриншот из Google Search Console, май 2023 г.Высокопроизводительный сервер имеет решающее значение. Он должен быть в состоянии справиться с объемом сканирования, которое робот Googlebot хочет выполнить, без какого-либо негативного влияния на время отклика сервера или возникновение ошибок.

Убедитесь, что статус хоста вашего сайта в Google Search Console зеленый, что ошибки 5xx составляют менее 1%, а время отклика сервера составляет менее 300 миллисекунд.

2. Удалите бесполезный контент

Когда значительная часть контента веб-сайта имеет низкое качество, устарела или дублируется, это отвлекает поисковых роботов от посещения нового или недавно обновленного контента, а также способствует раздуванию индекса.

Самый быстрый способ начать очистку — проверить отчет о страницах Google Search Console на наличие исключения «Просканировано — в настоящее время не проиндексировано».

В предоставленном образце найдите шаблоны папок или другие признаки проблемы. Для тех, кого вы найдете, исправьте это, объединив похожий контент с переадресацией 301 или удалив контент с 404, если это необходимо.

3. Укажите роботу Googlebot, что не сканировать

Хотя ссылки rel=canonical и теги noindex эффективны для поддержания индекса Google вашего веб-сайта в чистоте, они требуют дополнительных затрат на сканирование.

Хотя иногда это необходимо, подумайте, нужно ли вообще сканировать такие страницы. Если нет, остановите Google на этапе сканирования с помощью запрета robot.txt.

Найдите случаи, когда блокировка поискового робота может быть лучше, чем предоставление инструкций по индексации, просмотрев в отчете о покрытии Google Search Console исключения из канонических тегов или тегов noindex.

Кроме того, просмотрите образец URL-адресов «Проиндексировано, не отправлено в карту сайта» и «Обнаружено — в настоящее время не проиндексировано» в Google Search Console. Найдите и заблокируйте маршруты, не относящиеся к SEO, такие как:

- Страницы параметров, такие как ?sort=oldest.

- Функциональные страницы, такие как «корзина».

- Бесконечные пробелы, например созданные страницами календаря.

- Неважные изображения, сценарии или файлы стилей.

- URL-адреса API.

Вы также должны учитывать, как ваша стратегия нумерации страниц влияет на сканирование.

4. Проинструктируйте робота Googlebot, что и когда сканировать

Оптимизированная карта сайта в формате XML — это эффективный инструмент, помогающий роботу Googlebot находить релевантные для SEO URL-адреса.

Оптимизированный означает, что он динамически обновляется с минимальной задержкой и включает дату и время последнего изменения, чтобы информировать поисковые системы, когда страница в последний раз была значительно изменена и нужно ли ее повторно сканировать.

5. Поддержка сканирования по внутренним ссылкам

Мы знаем, что сканирование может происходить только по ссылкам. XML-карты сайта — отличное место для начала; внешние ссылки эффективны, но их сложно создать в больших объемах с высоким качеством.

С другой стороны, внутренние ссылки относительно легко масштабировать, и они оказывают значительное положительное влияние на эффективность сканирования.

Уделите особое внимание мобильной навигации по всему сайту, хлебным крошкам, быстрым фильтрам и ссылкам на связанный контент — следите за тем, чтобы ни один из них не зависел от Javascript.

Оптимизируйте веб-сканирование

Надеюсь, вы согласны: сканирование веб-сайтов имеет фундаментальное значение для SEO.

И теперь у вас есть реальный KPI эффективности сканирования для измерения оптимизаций — так что вы можете вывести свою органическую производительность на новый уровень.

Дополнительные ресурсы:

Рекомендуемое изображение: BestForBest/Shutterstock