Обновлено: 29 июля 2023 г.

Узнайте, что это значит и является ли проблемой, если ваша XML-карта сайта не указана в robots.txt.

Файлы Sitemap и robots.txt служат важным целям сканирования и индексации поисковыми системами.

Карта сайта — это XML-файл, в котором перечислены все страницы веб-сайта. Это позволяет поисковым системам, таким как Google, более эффективно сканировать сайт, информируя их обо всех URL-адресах, которые необходимо проиндексировать. Карта сайта особенно полезна для сайтов с большим количеством страниц.

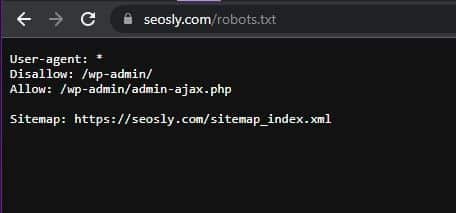

Файл robots.txt содержит инструкции по сканированию для поисковых роботов. Он может перечислять части сайта, к которым нельзя обращаться или которые нельзя индексировать (хотя это не является его основной целью). В файле robots.txt также обычно указывается расположение карты сайта с помощью такой строки:

Sitemap:

Однако многие сайты вообще опускают ссылку на карту сайта в файле robots.txt. В некоторых случаях это может привести к проблемам с индексацией, но в других случаях это может не иметь значения.

В этой статье мы рассмотрим, в каких случаях отсутствие карты сайта в robots.txt может быть проблематичным, а в каких случаях это допустимо.

Содержание

TL;DR: Sitemap.xml не указан в robots.txt

Когда ваш сайт должен иметь карту сайта, указанную в robots.txt

Файл robots.txt служит инструкцией для сканеров поисковых систем, посещающих веб-сайт. Обычно это самый первый файл, к которому они обращаются для определения директив индексации.

Указав местоположение карты сайта в robots.txt, вы немедленно уведомите поисковых ботов о ее существовании, как только они начнут сканирование. Это делает URL-адрес карты сайта одной из первых страниц, извлекаемых и анализируемых.

Наличие карты сайта, объявленной в robots.txt, имеет решающее значение для:

- Крупные сайты с обширным контентом – Карты сайта позволяют более эффективно обнаруживать все URL-адреса на сайтах с тысячами или миллионами страниц. Его отсутствие может привести к замедлению индексации.

- Сайты, которые часто добавляют или обновляют контент – Благодаря предварительному указанию карты сайта новые и измененные страницы обнаруживаются быстрее, поскольку сайт периодически повторно сканируется.

- Совершенно новые веб-сайты все еще получают первоначальную индексацию – Включение URL-адреса карты сайта помогает поисковым роботам обнаруживать начальный контент нового сайта и быстрее начинать его индексацию.

- Сайты, восстанавливающиеся после серьезных проблем с индексацией — Повторное добавление карты сайта после таких проблем, как взлом, помогает восстановить потерянные страницы (но в этом есть гораздо больше нюансов).

- Файлы Sitemap, расположенные по нестандартным адресам – Без robots.txt боты могут не найти карты сайта в необычных местах, таких как /xml-sitemap.xml.

- Любой тип сайта, если карта сайта не была отправлена в Search Console. – Robots.txt обеспечивает избыточность, если карта сайта не была зарегистрирована напрямую в Google.

Общей чертой является то, что объявление карты сайта в robots.txt дает Google отчетливое представление о ее существовании. Поисковые боты будут сканировать и анализировать его на ранней стадии при первом сканировании веб-сайта. Карта сайта может быть отправлена непосредственно в Search Console, а файл robots.txt фиксирует появление новых ботов и повторное сканирование в будущем.

Дайте мне знать, если вы хотите, чтобы я изменил или добавил что-либо в этот более подробный раздел!

Если вашему сайту не нужна XML-карта сайта, указанная в robots.txt

Для некоторых веб-сайтов не обязательно указывать URL-адрес карты сайта в файле robots.txt. Его отсутствие может вообще не вызвать никаких проблем.

Типы сайтов, которые, скорее всего, не требуют ссылки на карту сайта в robots.txt, включают:

- Небольшие веб-сайты с очень минимальным количеством страниц – На сайтах с небольшим количеством страниц поисковые роботы могут обнаруживать и индексировать контент без карты сайта.

- Веб-сайты со статическим, неизменяемым контентом. – Если контент остается неизменным в течение длительного времени, периодические повторные сканирования менее важны, поэтому более быстрое обнаружение с помощью карты сайта менее полезно.

- Хорошо зарекомендовавшие себя сайты, которые уже полностью проиндексированы – На зрелых сайтах с более чем 1000 страниц, которые уже сканируют боты, карта сайта может дать небольшую дополнительную ценность.

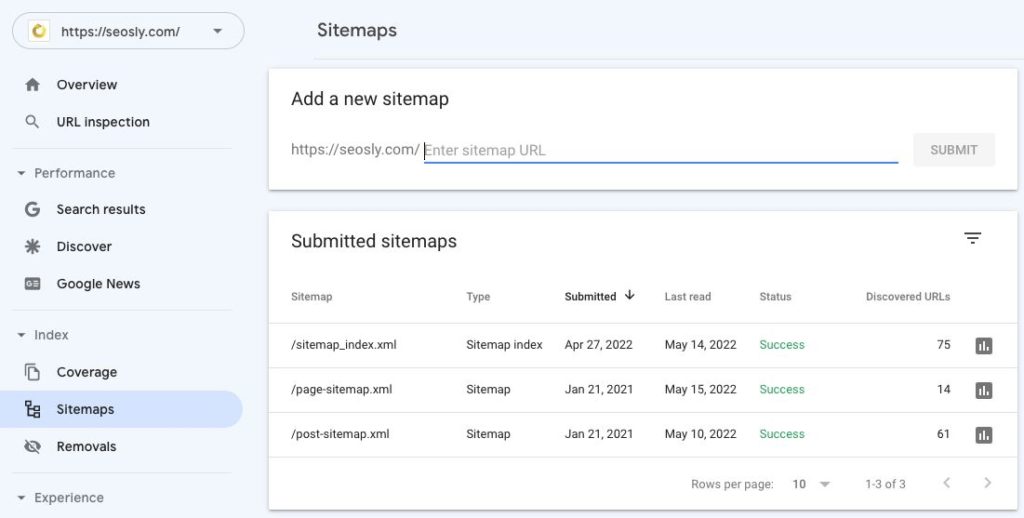

- Сайты, чьи карты сайта правильно представлены в Search Console – Пока Google знает о карте сайта напрямую и активно ее сканирует, избыточность в robots.txt не требуется.

- Контент с низким приоритетом, который не нуждается в индексации – Для сайтов, не связанных с исчерпывающей индексацией, карта сайта может не иметь значения.

Общим является то, что все эти типы сайтов имеют меньшую потребность в быстром обнаружении и мониторинге изменений, что облегчает объявление карты сайта в robots.txt.

Пока Google в достаточной степени сканирует новый и существующий контент с помощью регулярных периодических проверок, упущение может иметь минимальные последствия.

Тем не менее, добавление ссылки на карту сайта по-прежнему является хорошей практикой, когда это возможно. У него есть несколько недостатков, и он обеспечивает такие преимущества, как избыточность и более быстрое определение приоритетов сканирования.

Бонус: советы и рекомендации по работе с файлами Sitemap

Вот несколько рекомендаций по работе с XML-картами сайта:

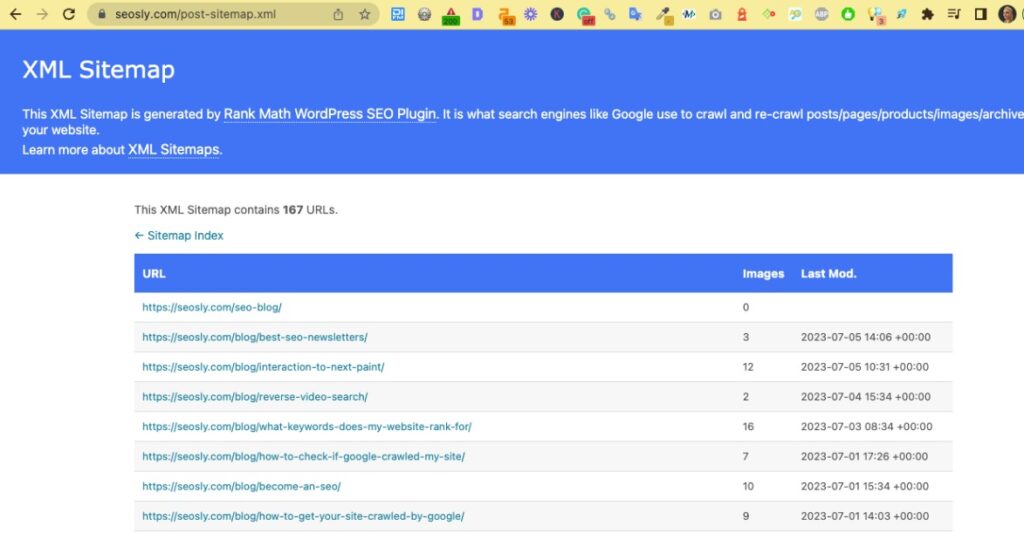

- Убедитесь, что карта сайта содержит действительные URL-адреса – Избегайте включения ошибок 404, перенаправленных страниц или любых других несуществующих URL-адресов. Для крупных сайтов недопустимые URL-адреса в карте сайта могут стать проблемой краулингового бюджета и вызвать проблемы с индексацией.

- Отправить как в Google, так и в Bing – Загрузите карту сайта в Google Search Console и Bing Webmaster Tools. Это позволяет вам отслеживать, когда движки в последний раз обращались к вашей карте сайта и сталкивались ли они с какими-либо ошибками при ее сканировании. Не пренебрегайте Bing!

- Рассмотрите HTML-карту сайта – Карта сайта в формате HTML помогает пользователям лучше ориентироваться на вашем сайте визуально. При правильном оформлении с контекстными якорными текстовыми ссылками это также может помочь поисковым системам лучше понять структуру контента вашего сайта.

- Избегайте нескольких конфликтующих файлов Sitemap – Если ваша CMS, такая как WordPress, автоматически генерирует карты сайта, убедитесь, что вокруг нет нескольких или устаревших версий. Для сайтов WordPress рекомендуется использовать такой плагин, как Rank Math, для правильного создания карт сайта и управления ими.

- Регулярно обновляйте карту сайта – По мере изменения содержимого сайта обновляйте карту сайта, чтобы поисковые системы информировались о новых и измененных страницах. В большинстве случаев это должно происходить автоматически.

- Ограничьте дату последнего мода, если повторное сканирование всех страниц является чрезмерным – Для больших сайтов перечисление всех URL-адресов может превысить краулинговый бюджет. Отфильтруйте только недавно обновленные страницы.

- Сожмите XML-файл, чтобы оптимизировать влияние сканирования. – Уменьшите требования к пропускной способности и ускорьте обработку за счет сжатия файла карты сайта.

У меня также есть видео, в котором я показываю вам, как проводить аудит XML-карты сайта: