Две тенденции повлияли на то, как Google индексирует. В то время как открытая сеть сократилась, Google необходимо сканировать крупные контент-платформы, такие как YouTube, Reddit и TikTok, которые часто построены на «сложных» JS-фреймворках, чтобы найти новый контент. В то же время ИИ меняет базовую динамику сети, делая посредственный и плохой контент излишним.

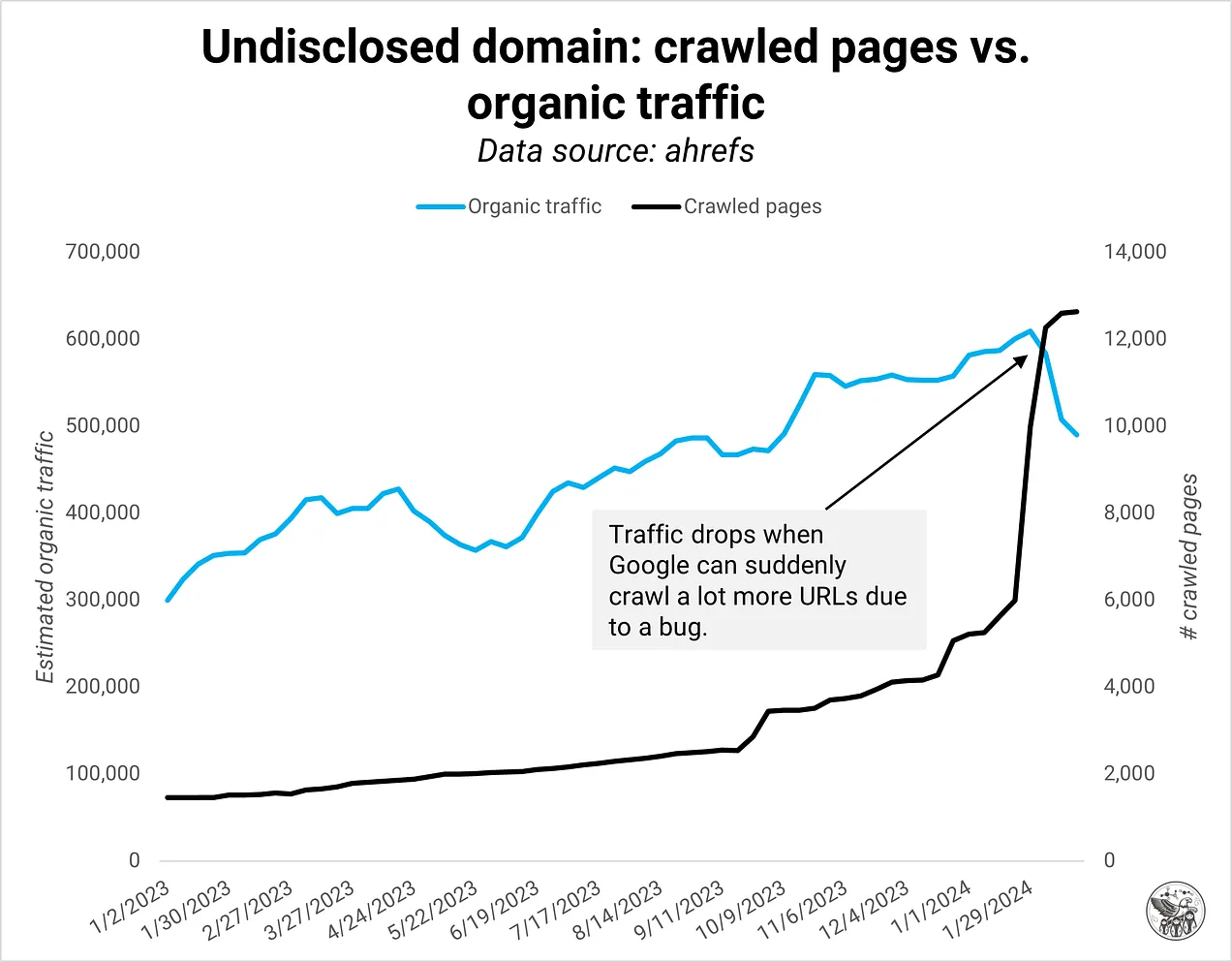

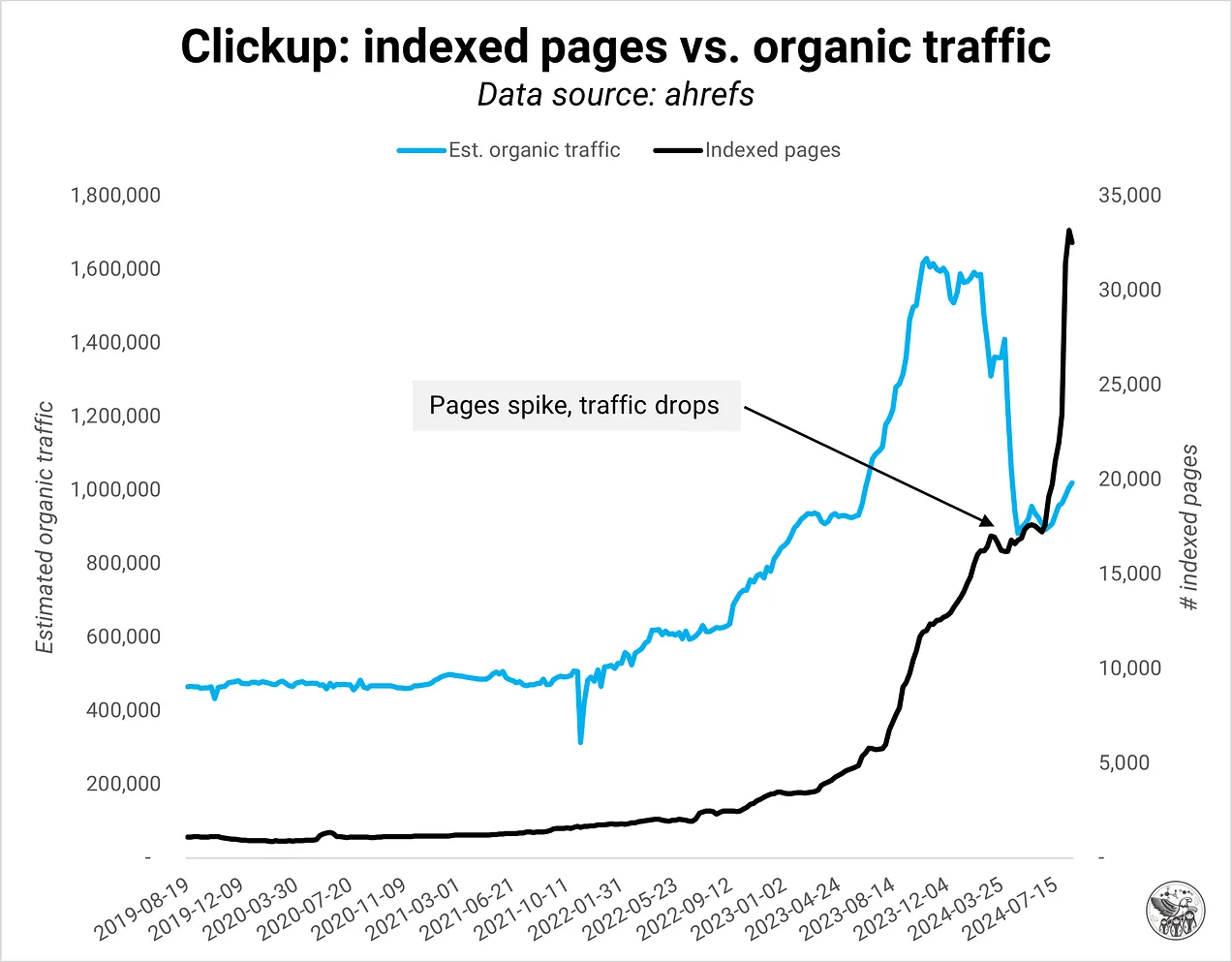

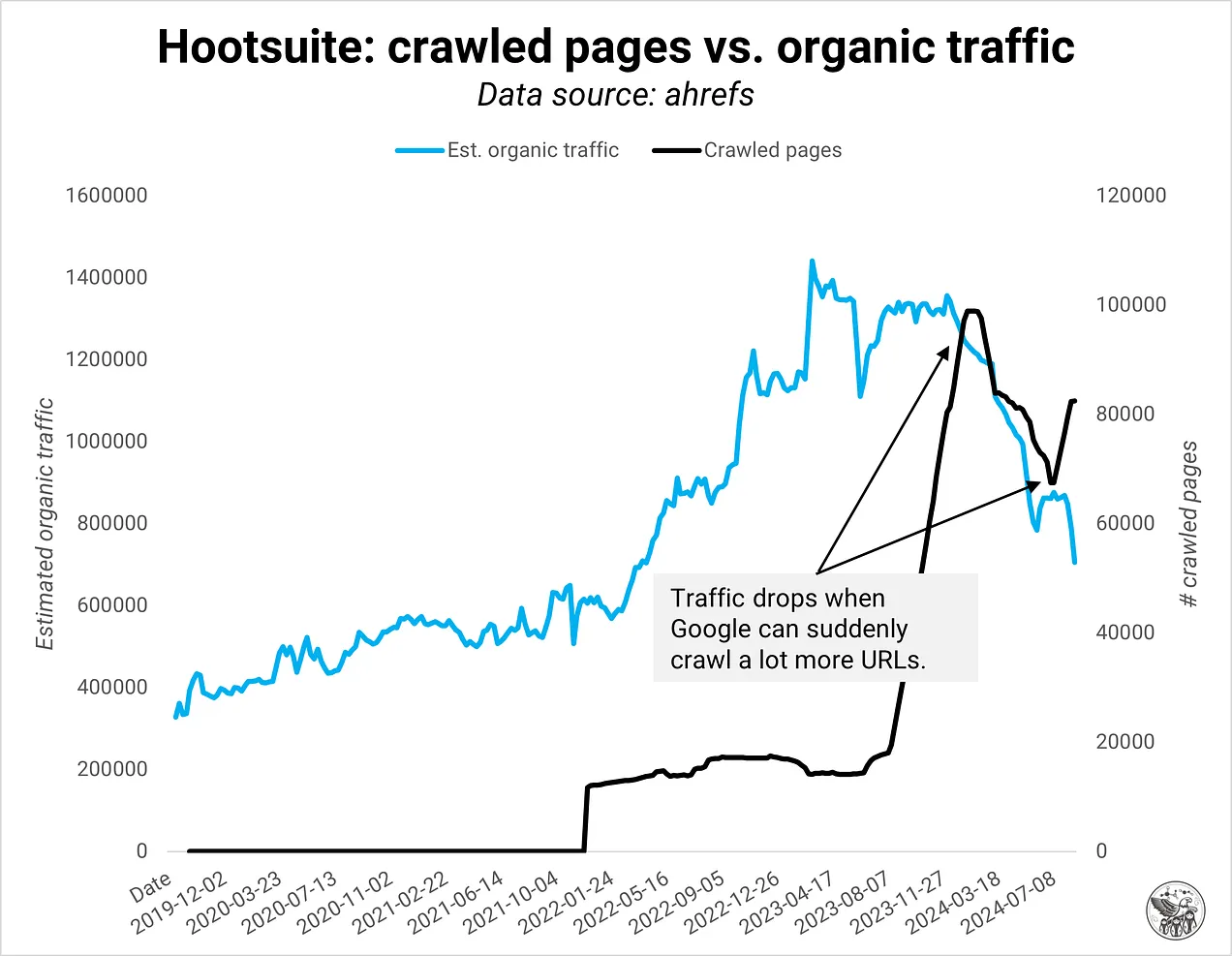

В своей работе с некоторыми из крупнейших сайтов в Интернете я недавно заметил обратную зависимость между индексированными страницами и органическим трафиком. Больше страниц не обязательно плохие, но часто не соответствуют ожиданиям Google по качеству. Или, говоря лучше, определение качества изменилось. Ставки для SEO-специалистов высоки: слишком агрессивное расширение может пострадать весь ваш домен. Нам нужно изменить наше мышление относительно качества и разработать системы мониторинга, которые помогут нам понять качество домена на уровне страницы.

Сытый

Google изменил подход к доменам, начиная примерно с октября 2023 года: ни один пример не показывал обратную зависимость до октября. Кроме того, у Google были проблемы с индексацией, когда они запустили обновление алгоритма Core в октябре 2023 года, так же, как это произошло сейчас во время обновления в августе 2024 года.

До этого изменения Google индексировал все и отдавал приоритет контенту самого высокого качества на домене. Подумайте об этом как о промывке золота, когда вы наполняете кастрюлю гравием, почвой и водой, а затем взбалтываете и перемешиваете, пока не останется только ценный материал.

Теперь домен и его контент должны зарекомендовать себя, прежде чем Google даже попытается добыть золото. Если в домене слишком много некачественного контента, Google может проиндексировать только некоторые страницы или вообще ни одной в крайних случаях.

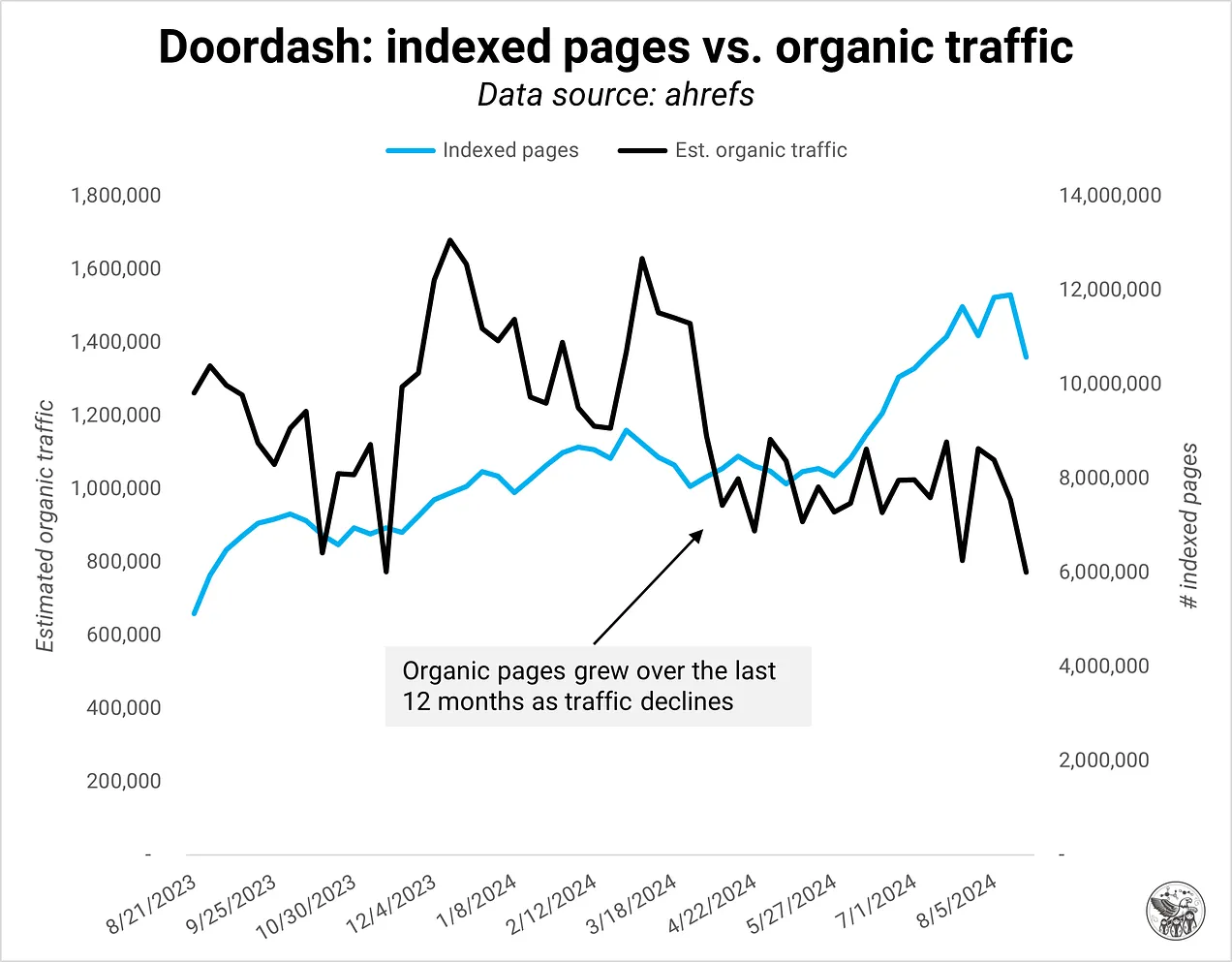

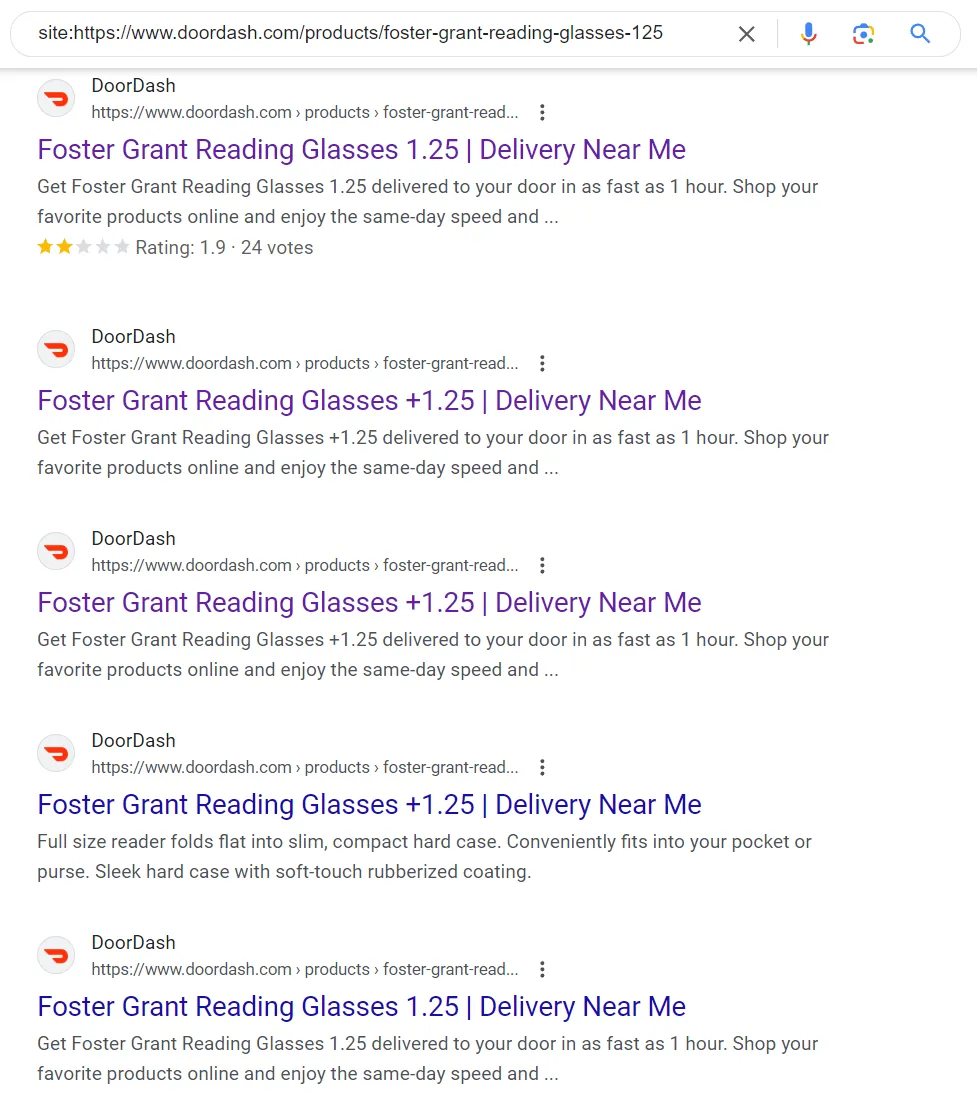

Одним из примеров является doordash.comкоторый добавил много страниц за последние 12 месяцев и потерял органический трафик в процессе. По крайней мере некоторые, а может и все, новые страницы не соответствовали ожиданиям Google по качеству.

Кредит изображения: Кевин Индиг

Кредит изображения: Кевин ИндигНо почему? Что изменилось? Я рассуждаю так:

- Google стремится экономить ресурсы и затраты, переходя к повышению операционной эффективности.

- Частичная индексация более эффективна против некачественного контента и спама. Вместо того, чтобы индексировать и затем пытаться ранжировать новые страницы домена, Google наблюдает за общим качеством домена и относится к новым страницам с соответствующим скептицизмом.

- Если домен постоянно производит некачественный контент, у него нет возможности еще больше загрязнять индекс Google.

- Планка качества Google возросла, поскольку в Интернете стало гораздо больше контента, а также для оптимизации индекса для RAG (основание Обзоры ИИ) и модели поездов.

Этот акцент на качестве домена как сигнале означает, что вам придется изменить способ мониторинга вашего веб-сайта, чтобы учитывать качество. Мой руководящий принцип: «Если вы не можете добавить ничего нового или лучшего в веб, то, скорее всего, он недостаточно хорош».

Качественная еда

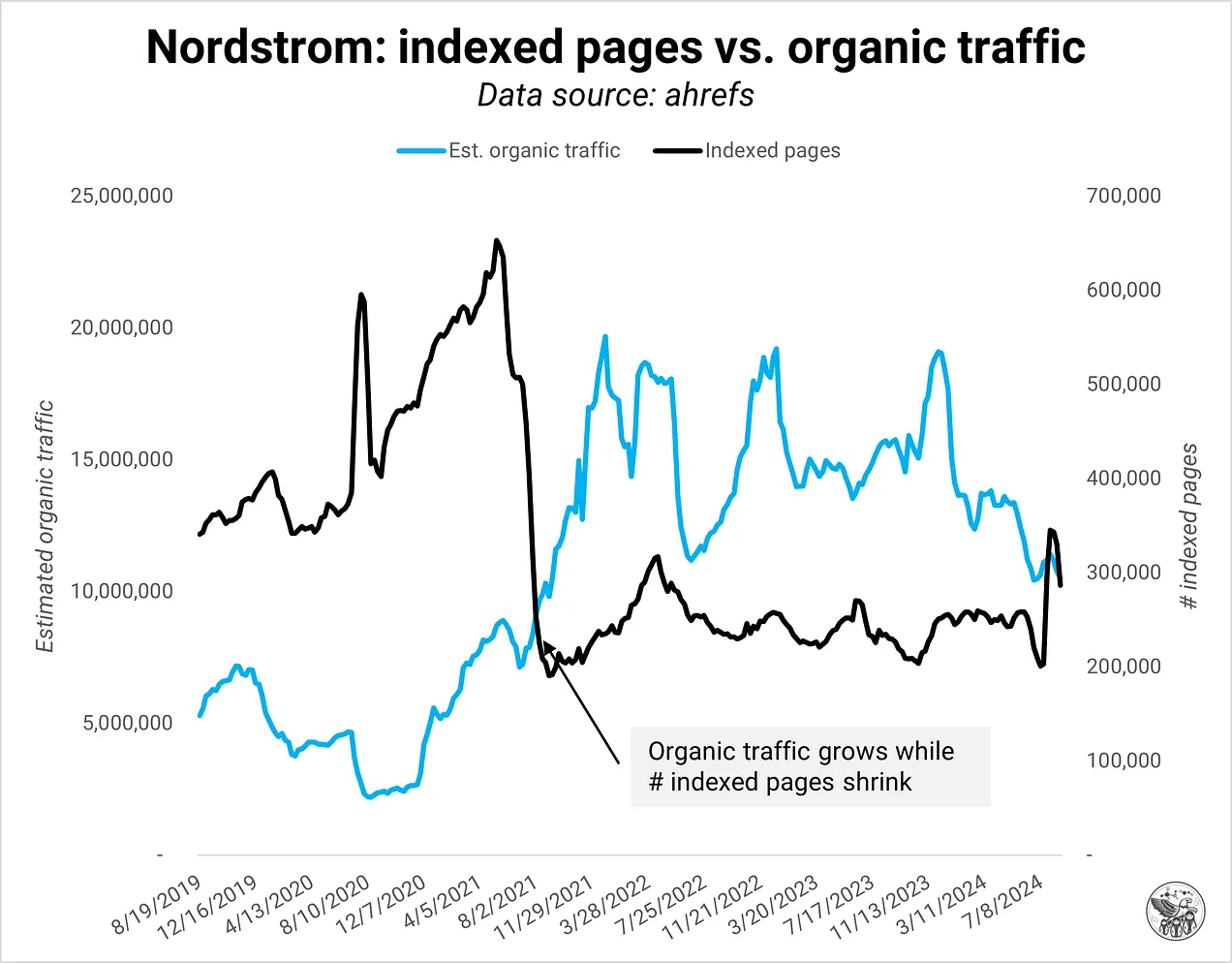

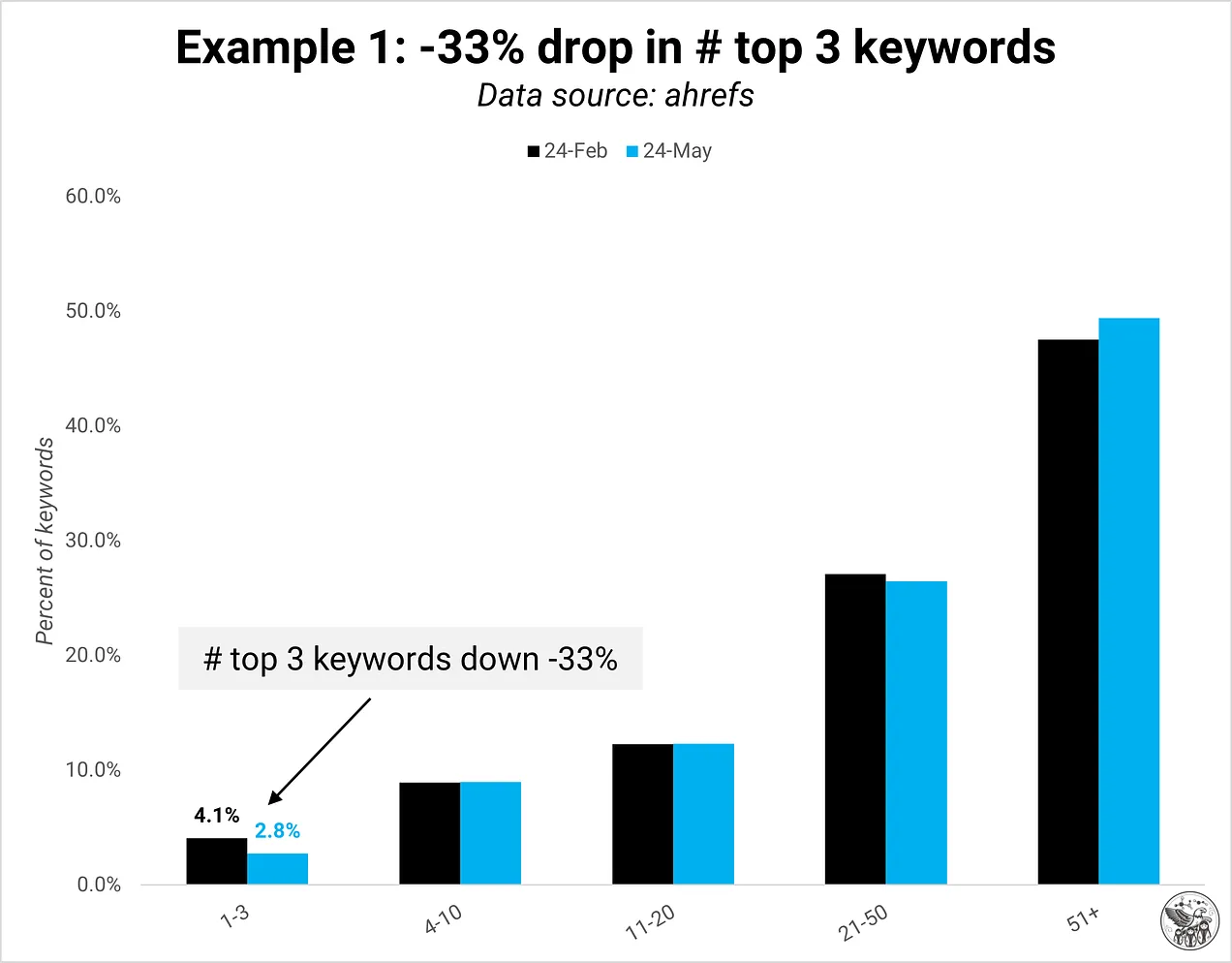

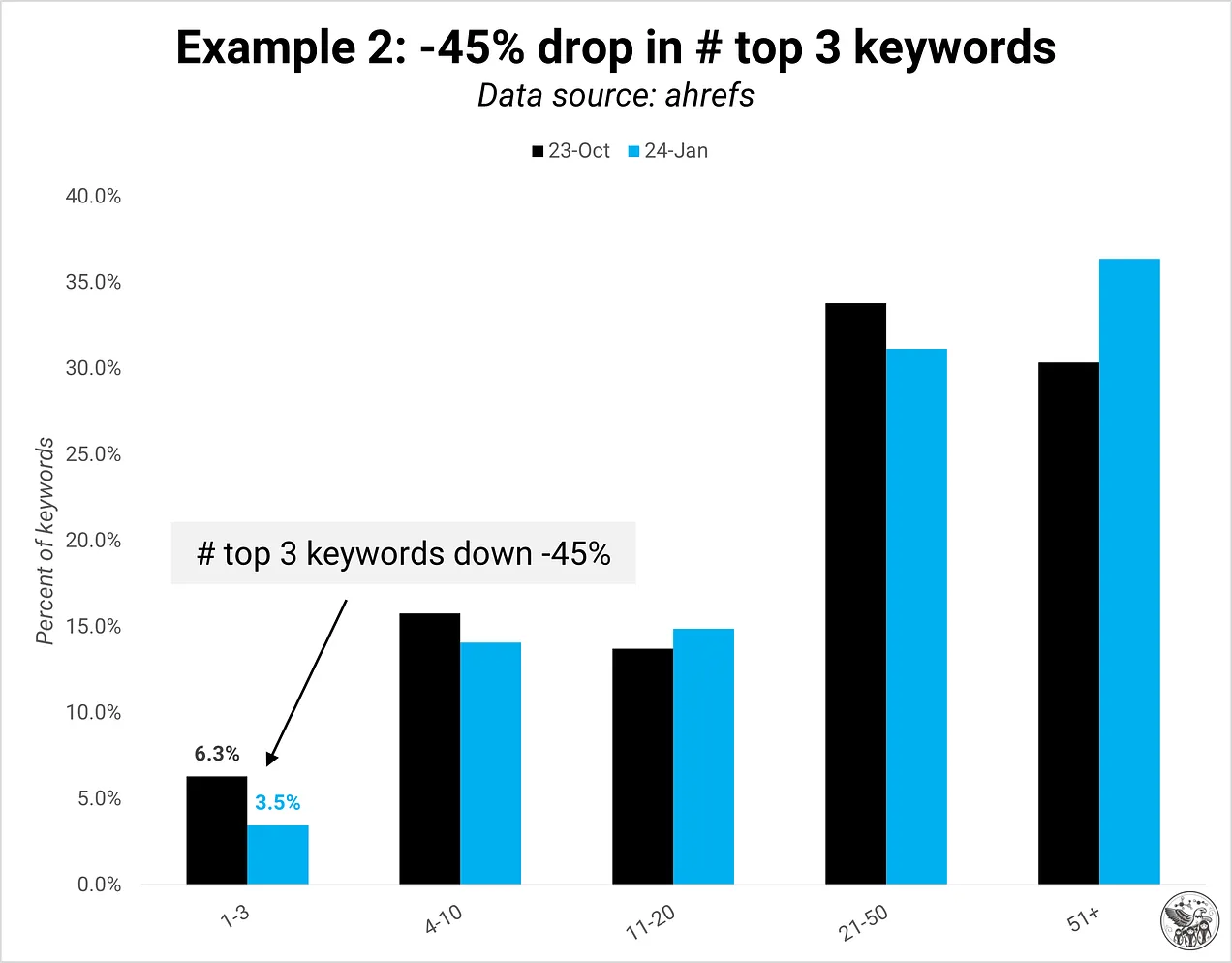

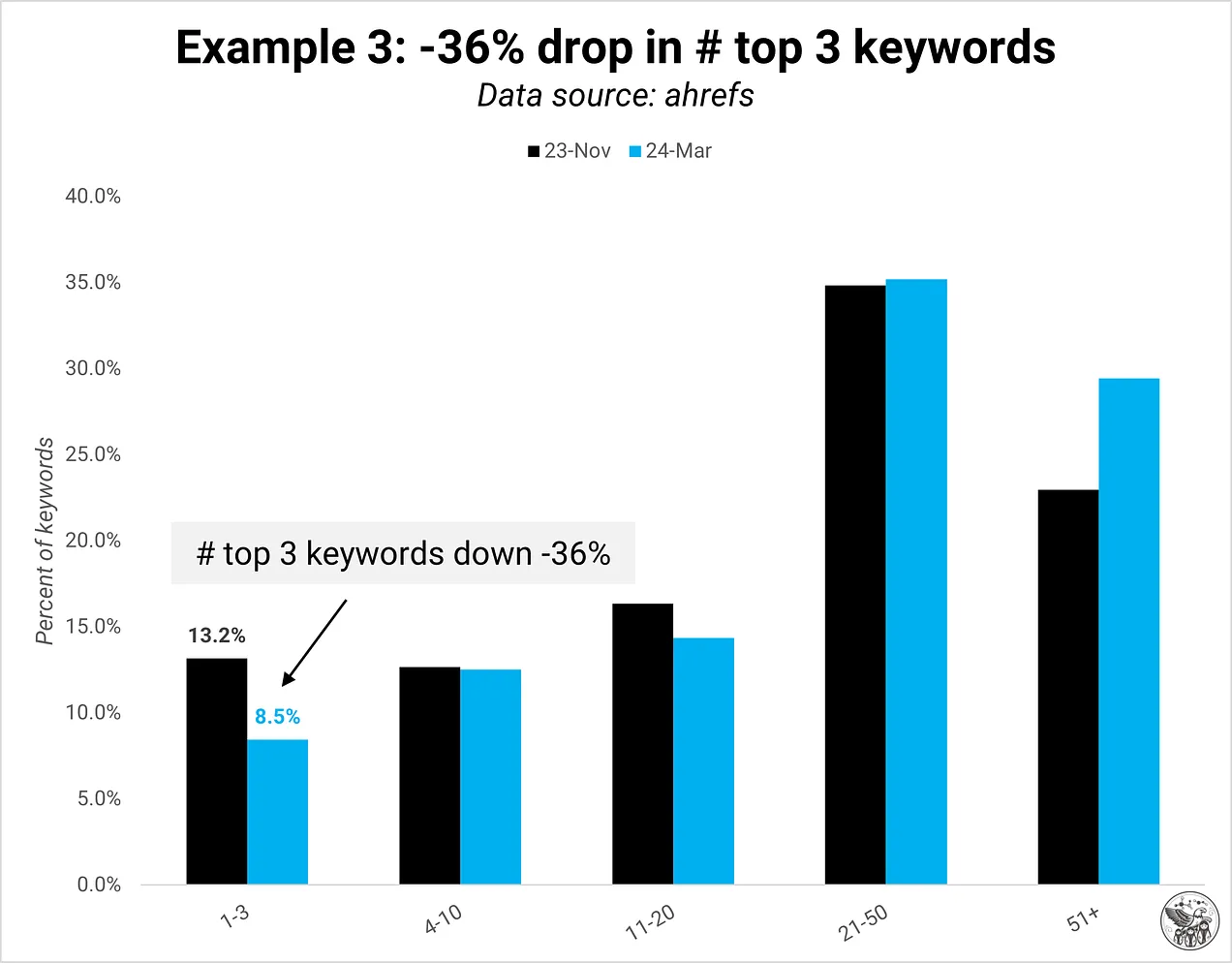

Качество домена — это мой термин для описания соотношения индексированных страниц, соответствующих стандарту качества Google, и не соответствующих ему. Обратите внимание, что только индексированные страницы учитываются в качестве. Максимальный процент «плохих» страниц, прежде чем Google сократит трафик на домен, неясен, но мы определенно можем увидеть, когда он будет достигнут:

Кредит изображения: Кевин Индиг

Кредит изображения: Кевин Индиг Кредит изображения: Кевин Индиг

Кредит изображения: Кевин Индиг Кредит изображения: Кевин Индиг

Кредит изображения: Кевин ИндигЯ определяю качество домена как сигнал, состоящий из трех областей: пользовательский опыт, качество контента и техническое состояние:

- Пользовательский опыт: находят ли пользователи то, что ищут?

- Качество контента: получение информациидизайн контента, полнота

- Технически оптимизировано: дублированный контент, рендеринг, контент на странице для контекста, «просканировано, не проиндексировано/не обнаружено»мягкие 404

Пример дублированного контента (Изображение предоставлено Кевином Индигом)

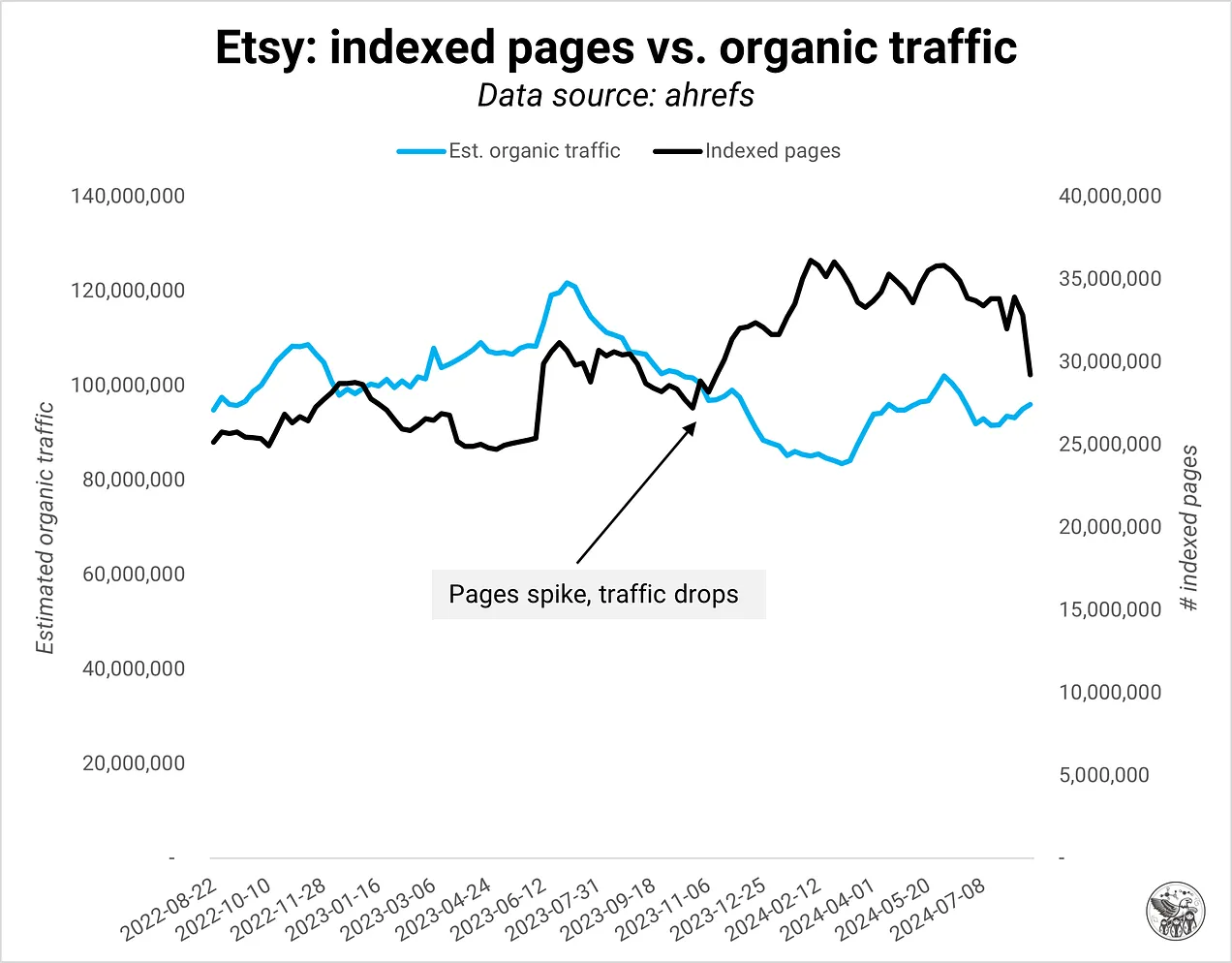

Пример дублированного контента (Изображение предоставлено Кевином Индигом)Внезапный всплеск индексированных страниц обычно указывает на техническую проблему, например дублирование контента из параметров, интернационализации или сломанных пагинаций. В примере ниже Google немедленно сократил органический трафик на этот домен, когда логика пагинации сломалась, что привело к большому количеству дублированного контента. Я никогда не видел, чтобы Google реагировал быстро на технические ошибки, но это новое состояние SEO, в котором мы находимся.

Кредит изображения: Кевин Индиг

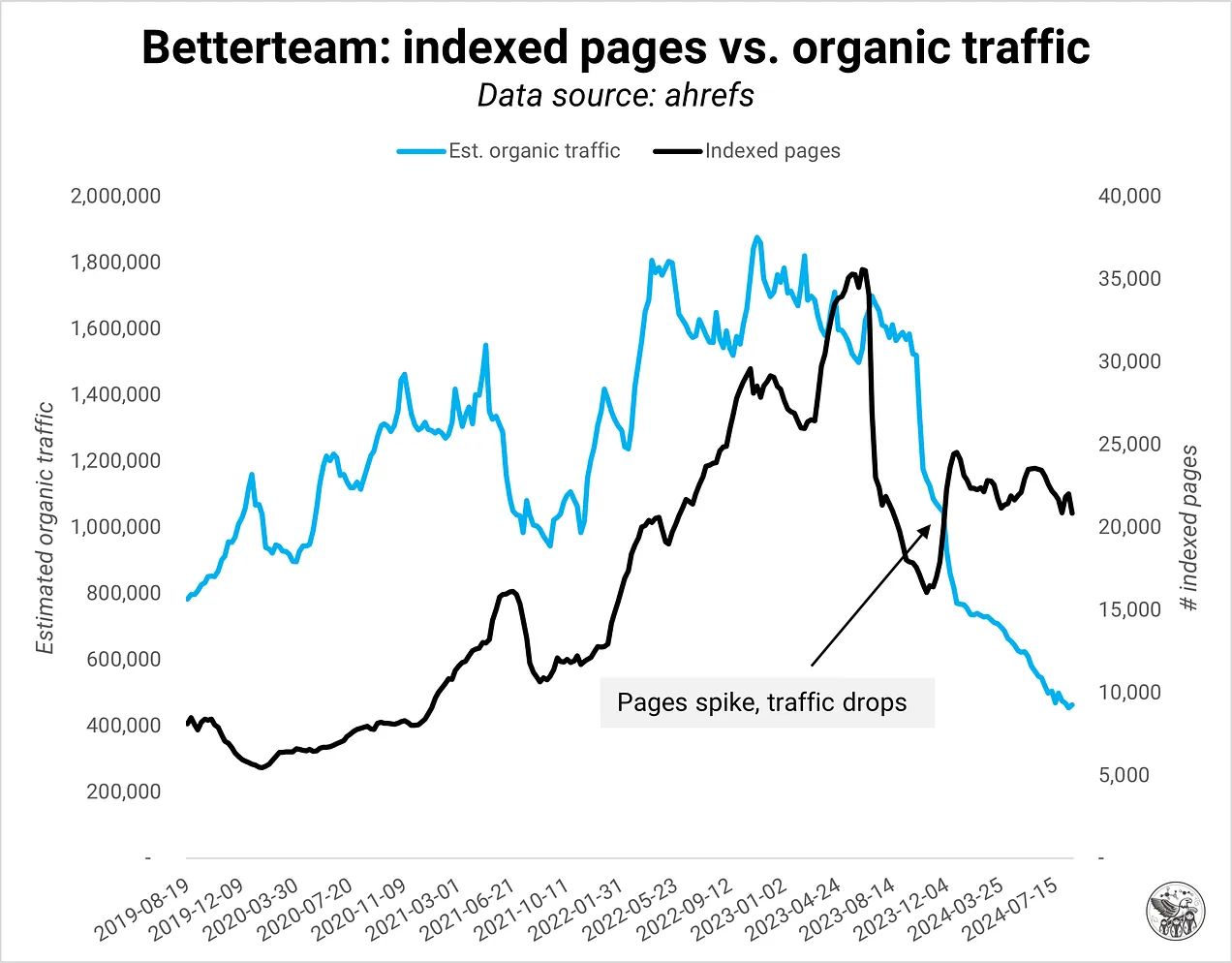

Кредит изображения: Кевин ИндигВ других случаях всплеск индексированных страниц указывает на программную SEO-игру, когда домен запустил много страниц на одном шаблоне. Когда качество контента на программных страницах недостаточно хорошее, Google быстро отключает кран трафика.

Кредит изображения: Кевин Индиг

Кредит изображения: Кевин Индиг Кредит изображения: Кевин Индиг

Кредит изображения: Кевин ИндигВ ответ Google часто сокращает количество ключевых слов, ранжирующихся в первых 3 позициях. Количество ключевых слов, ранжирующихся в других позициях, часто относительно стабильно.

Кредит изображения: Кевин Индиг

Кредит изображения: Кевин Индиг Кредит изображения: Кевин Индиг

Кредит изображения: Кевин Индиг Кредит изображения: Кевин Индиг

Кредит изображения: Кевин ИндигРазмер усугубляет проблему: качество домена может стать большей проблемой для крупных сайтов, хотя и более мелкие сайты также могут пострадать.

Добавление новых страниц на ваш домен само по себе не плохо. Вам просто нужно быть осторожным с этим. Например, публикация новых идей или маркетингового контента, который не нацелен напрямую на ключевое слово, все равно может быть очень ценным для посетителей сайта. Вот почему измерение вовлеченности и удовлетворенности пользователей в дополнение к показателям SEO имеет решающее значение.

План диеты

Самый важный способ убрать «жир» (страницы низкого качества) и снизить риск попадания под обновление Core — это установить правильную систему мониторинга. Трудно улучшить то, что вы не измеряете.

В центре система мониторинга качества домена — это панель мониторинга, которая отслеживает показатели для каждой страницы и сравнивает их со средним значением. Если бы я мог выбрать только три показателя, я бы измерил обратный показатель отказов, конверсии (мягкие и жесткие) и клики + рейтинги по типу страницы на страницу относительно среднего значения. В идеале ваша система оповещает вас, когда происходит скачок скорости сканирования, особенно для новых страниц, которые ранее не сканировались.

Как я пишу в Как лучшие компании измеряют качество контента:

1/ Для оценки качества продукции измеряйте такие показатели, как оценка SEO-редактора, оценка Flesch/читабельности или количество орфографических/грамматических ошибок.

2/ Для оценки качества производительности измеряйте такие показатели, как количество первых 3 мест, соотношение времени на странице и предполагаемого времени чтения, обратный показатель отказов, глубина прокрутки или ценность конвейера.

3/ Для обеспечения качества сохранения измеряйте показатели эффективности с течением времени и из года в год.

При мониторинге вашего сайта игнорируйте такие страницы, как «Условия обслуживания» или «О нас», поскольку их функция не связана с SEO.

Фаза усиления

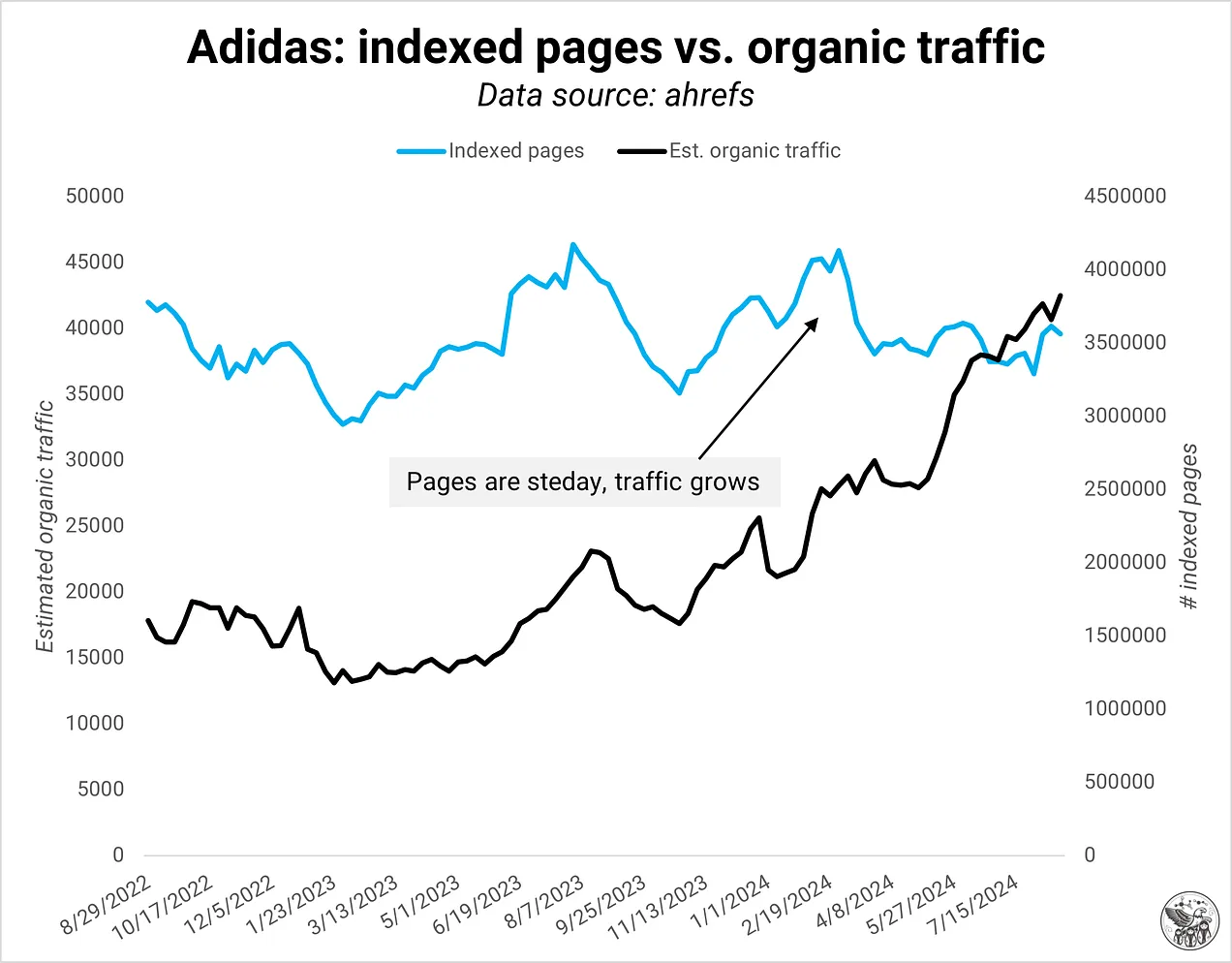

Мониторинг — первый шаг к пониманию качества домена вашего сайта. Вам не всегда нужно добавлять больше страниц для роста. Часто вы можете улучшить свой существующий инвентарь страниц, но вам нужна система мониторинга, чтобы понять это в первую очередь.

Adidas — хороший пример домена, который смог увеличить органический трафик просто за счет оптимизации своих существующих страниц.

Кредит изображения: Кевин Индиг

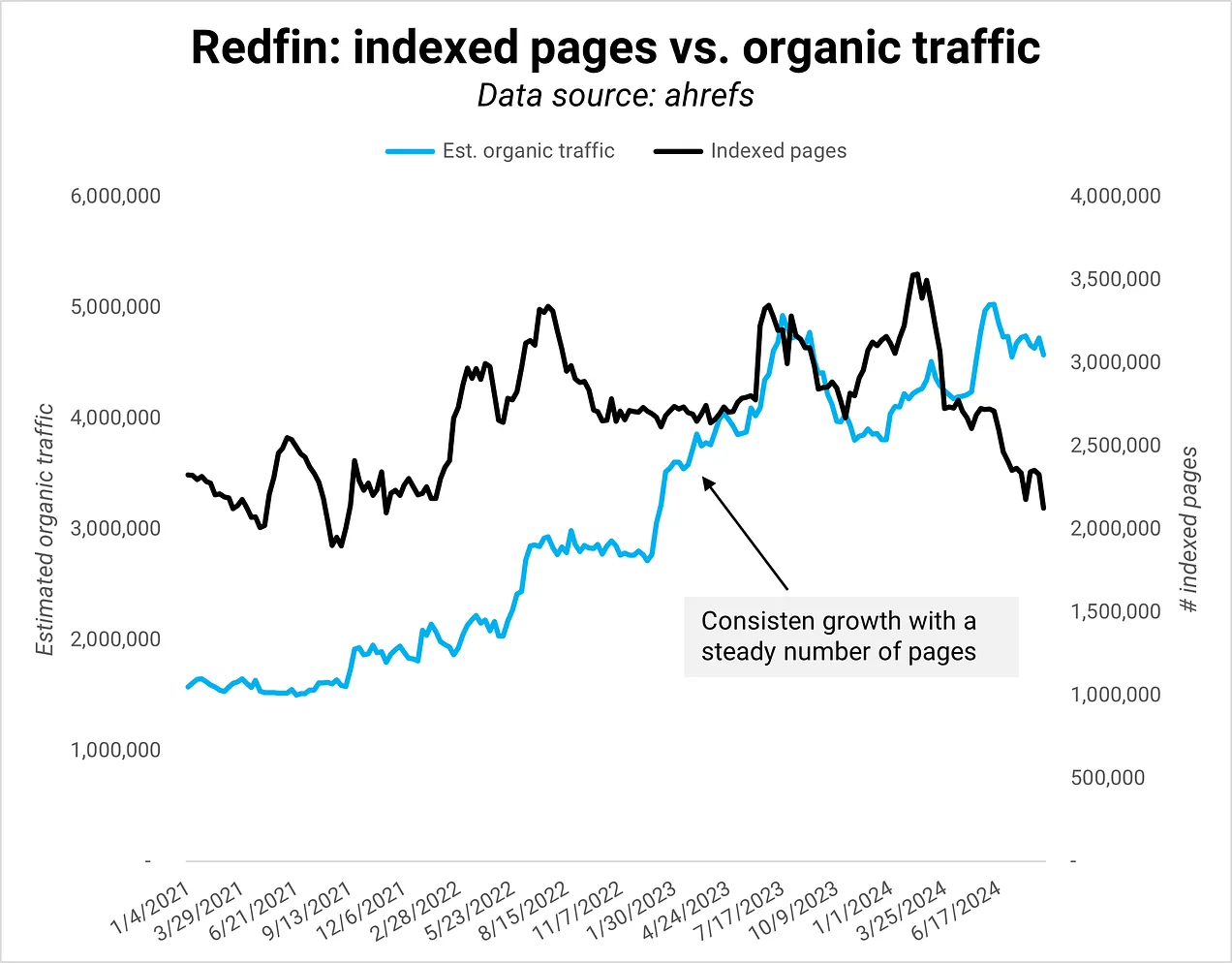

Кредит изображения: Кевин ИндигДругим примером является Redfin, который сохранил постоянное количество страниц, при этом значительно увеличив органический трафик.

Кредит изображения: Кевин Индиг

Кредит изображения: Кевин ИндигЦитата старшего директора по развитию продукта в моем Глубокое погружение в Redfin о достижении нужной планки качества:

Привнесение на сайт нашего местного опыта — мы являемся авторитетом на рынке жилья, отвечаем на вопросы о том, каково это — жить в том или ином районе, предлагаем полный набор объектов недвижимости для продажи и аренды по всей территории Соединенных Штатов.

Поддержание технического совершенства – наш сайт большой (более 100 млн страниц), поэтому мы не можем спать спокойно о таких вещах, как производительность, работоспособность сканирования и качество данных. Иногда наименее «сексуальные» усилия могут быть наиболее эффективными».

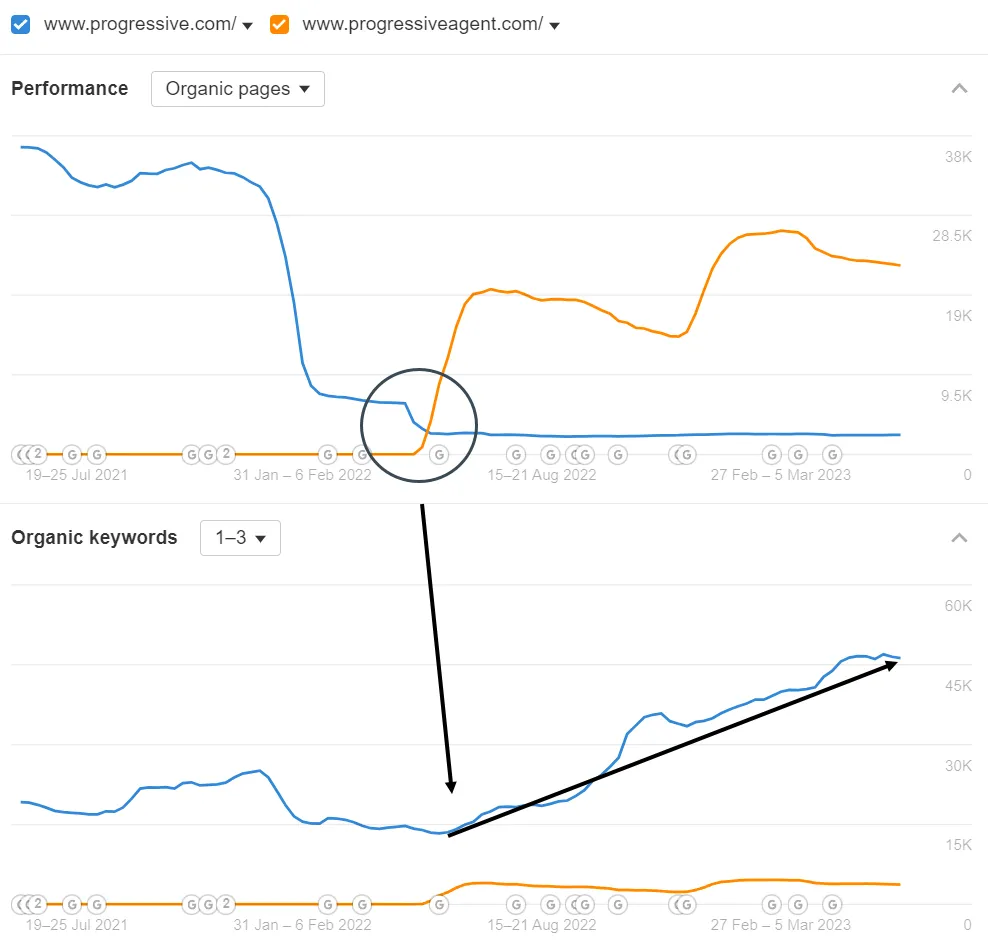

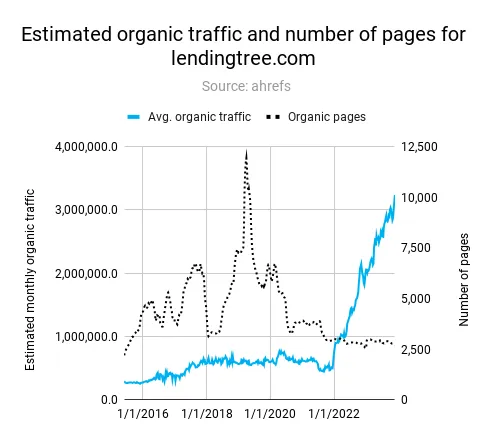

Такие компании, как Кредитное дерево или Прогрессивный добились значительных успехов за счет сокращения количества страниц, не соответствующих стандартам качества (см. скриншоты из Deep Dives ниже).

Progressive переместил страницы агентов на отдельный домен, чтобы повысить качество своего основного домена. (Автор изображения: Кевин Индиг)

Progressive переместил страницы агентов на отдельный домен, чтобы повысить качество своего основного домена. (Автор изображения: Кевин Индиг) LendingTree удалил множество некачественных страниц, чтобы увеличить рост органического трафика. (Автор изображения: Кевин Индиг)

LendingTree удалил множество некачественных страниц, чтобы увеличить рост органического трафика. (Автор изображения: Кевин Индиг)Заключение

Google вознаграждает сайты, которые остаются в форме. В 2020 году я писал о том, как Индекс Google может оказаться меньше, чем мы думаем. Размер индекса был целью в самом начале. Но сегодня речь идет не столько об индексировании как можно большего количества проиндексированных страниц, сколько о наличии правильных страниц. Определение «хорошего» претерпело изменения. Google более разборчив в том, кого пускать в клуб.

В той же статье я выдвинул гипотезу, что Google перейдет на API индексации и позволит владельцам сайтов взять на себя ответственность за индексацию. Это не осуществилось, но можно сказать, что Google использует больше API для индексации:

- Соглашение между Google и Reddit на сумму 60 долларов в год обеспечивает одну десятую результатов поиска Google (при условии, что Reddit присутствует в первой десятке почти по каждому ключевому слову).

- В электронная коммерциягде больше органических объявлений отображаются выше в результатах поискаGoogle больше полагается на фид товаров в Merchant Center для индексации новых товаров и формирования своего Shopping Graph.

- Такие функции SERP, как Главные новости, которые имеют решающее значение в Новостная индустрияпредставляют собой небольшие сервисы с собственной логикой индексации.

Заглядывая вперед, главный вопрос об индексации заключается в том, как она изменится, когда больше пользователей будут искать через обзоры ИИ и чат-ботов ИИ. Если предположить, что LLM по-прежнему должны будут уметь отображать страницы, техническая работа по SEO остается важной, однако мотивация индексации меняется с отображения веб-результатов на обучение моделей. В результате ценность страниц, которые не предлагают ничего нового, будет еще ближе к нулю, чем сегодня.