Понимание разницы между поисковыми ботами и скребками имеет решающее значение для SEO.

Споры на веб -сайте делятся на две категории:

- Первопартийные боты, которые вы используете для аудита и оптимизации вашего собственного сайта.

- Сторонние боты, которые ползут ваш сайт снаружи-иногда для индексации вашего контента (например, Googlebot), а в других случаях для извлечения данных (например, скребков конкурентов).

Это руководство разрушает первые лищики, которые могут улучшить технические SEO и сторонние боты вашего сайта, исследуя их влияние и как эффективно управлять ими.

Содержание

Первозависимые сканеры: добыча полезных ископаемых с вашего собственного веб-сайта

Crawlers могут помочь вам определить способы улучшения вашего технического SEO.

Повышение технической основы вашего сайта, архитектурной глубины и эффективности сканирования являются долгосрочной стратегией для увеличения поискового трафика.

Время от времени вы можете раскрыть серьезные проблемы, такие как файл robots.txt, блокирующий все поисковые боты на постановке, который оставался активным после запуска.

Исправление таких проблем может привести к немедленному улучшению видимости поиска.

Теперь давайте рассмотрим некоторые технологии, основанные на скале, которые вы можете использовать.

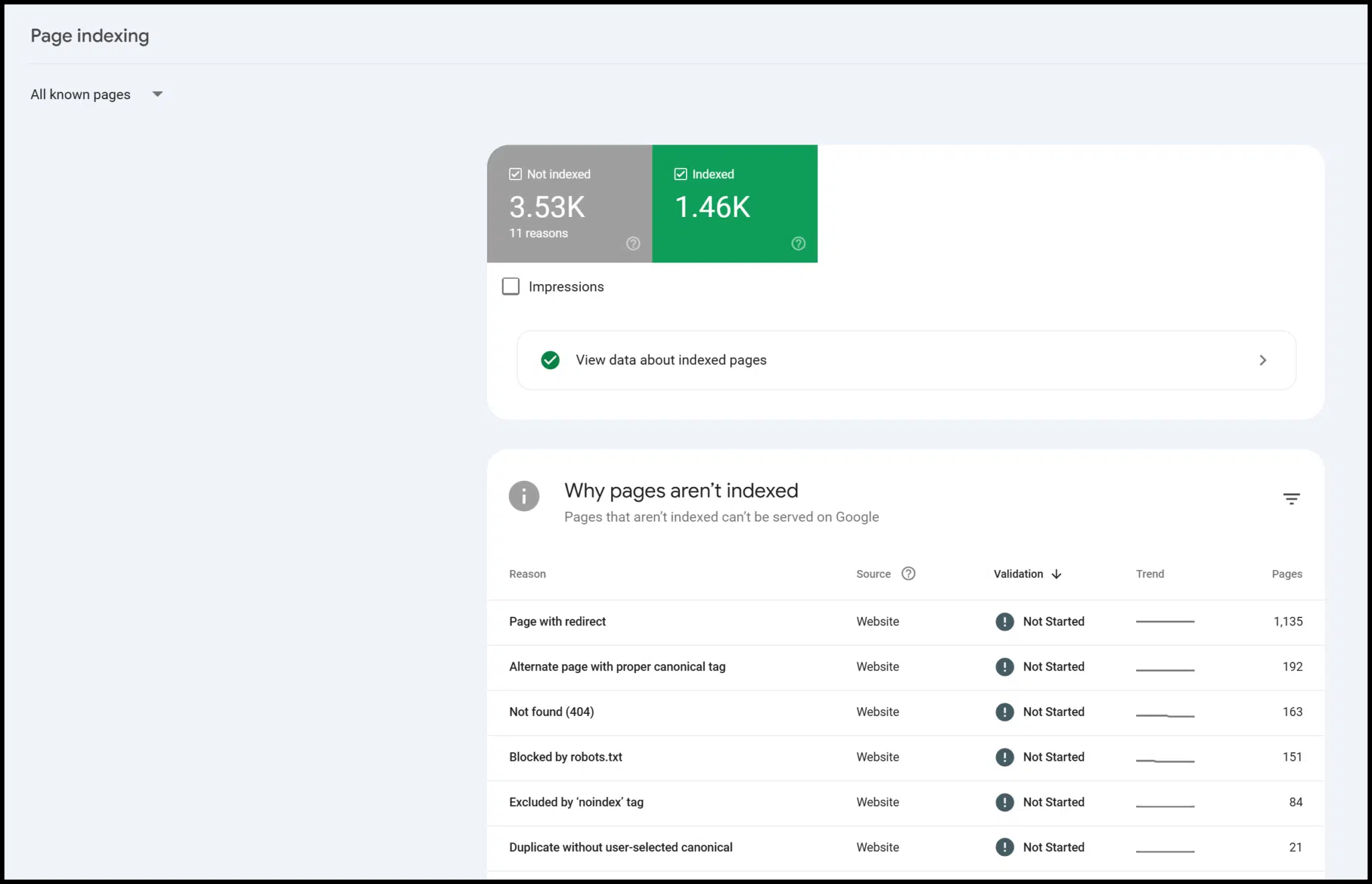

Googlebot через поисковую консоли

Вы не работаете в центре обработки данных Google, поэтому вы не можете запустить Googlebot, чтобы запустить свой собственный сайт.

Тем не менее, проверяя ваш сайт с помощью Google Search Console (GSC), вы можете получить доступ к данным и пониманию GoogleBot. (Следовать Руководство Google чтобы настроить себя на платформу.)

GSC бесплатно использовать и предоставляет ценную информацию — особенно об индексации страниц.

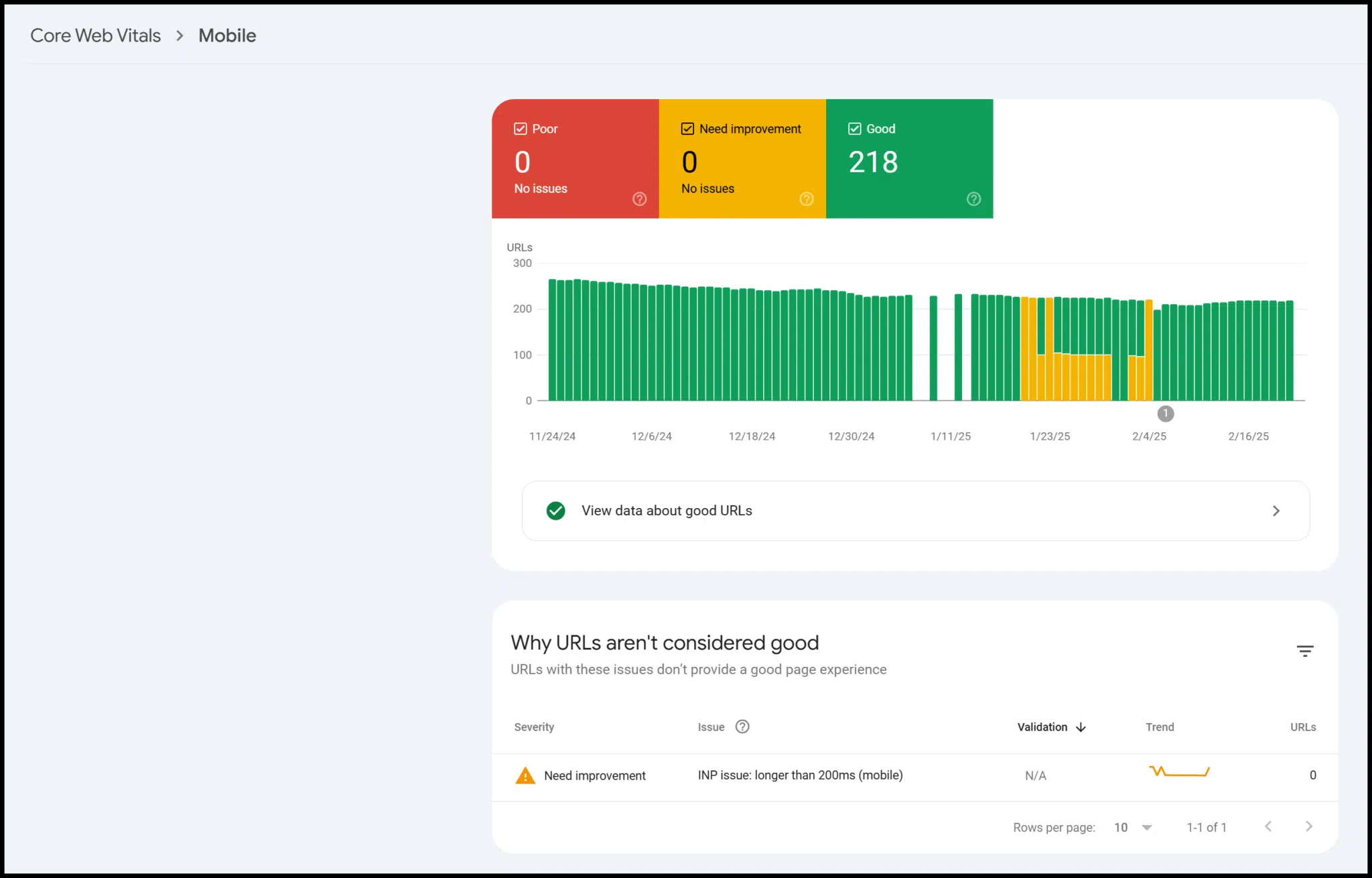

Также есть данные о мобильной связи, структурированных данных и основных вещах:

Технически, это сторонние данные от Google, но только проверенные пользователи могут получить к ним доступ для своего сайта.

На практике он функционирует так же, как данные из сканирования, который вы запускаете сами.

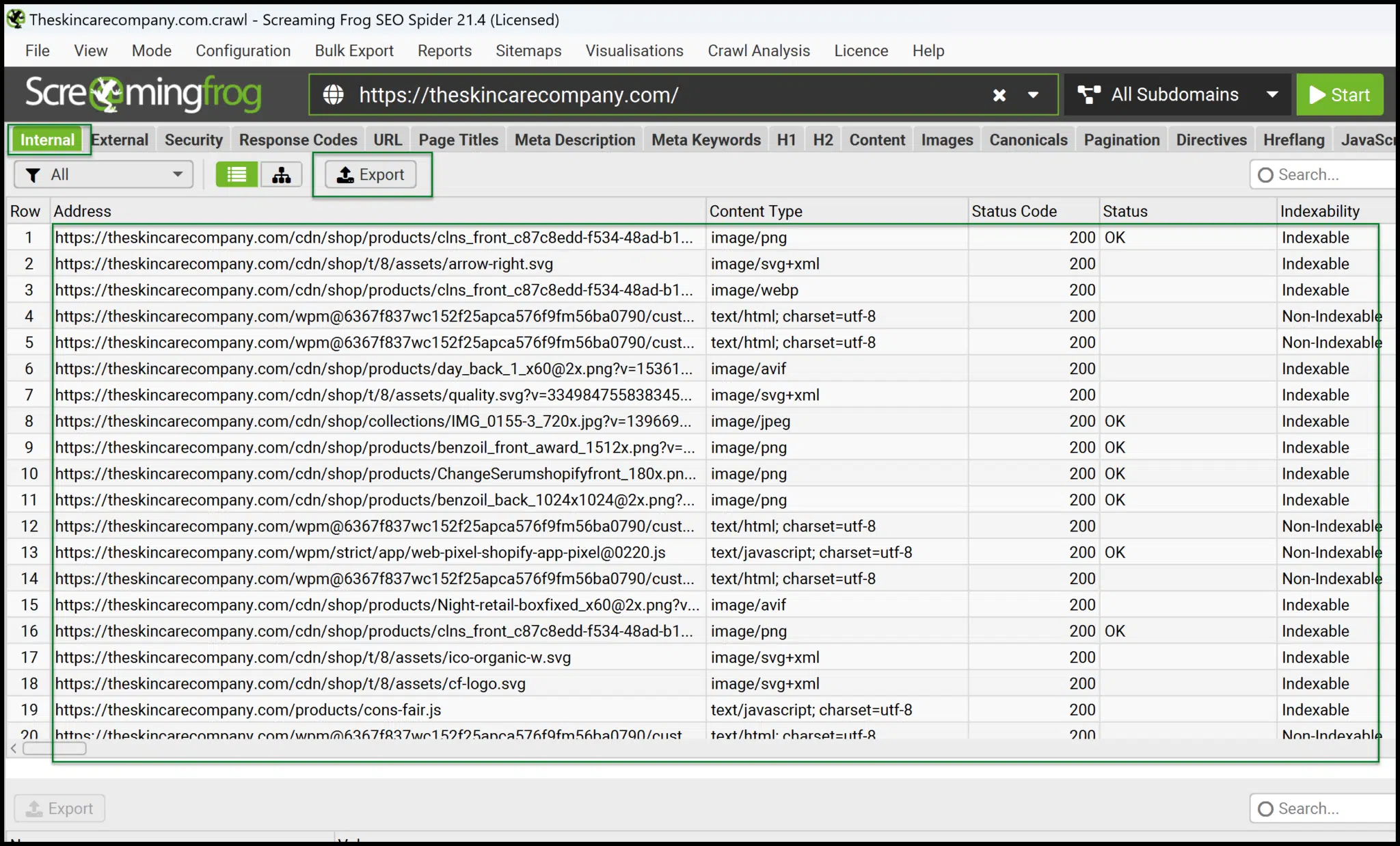

Кричащая лягушка Seo Spider

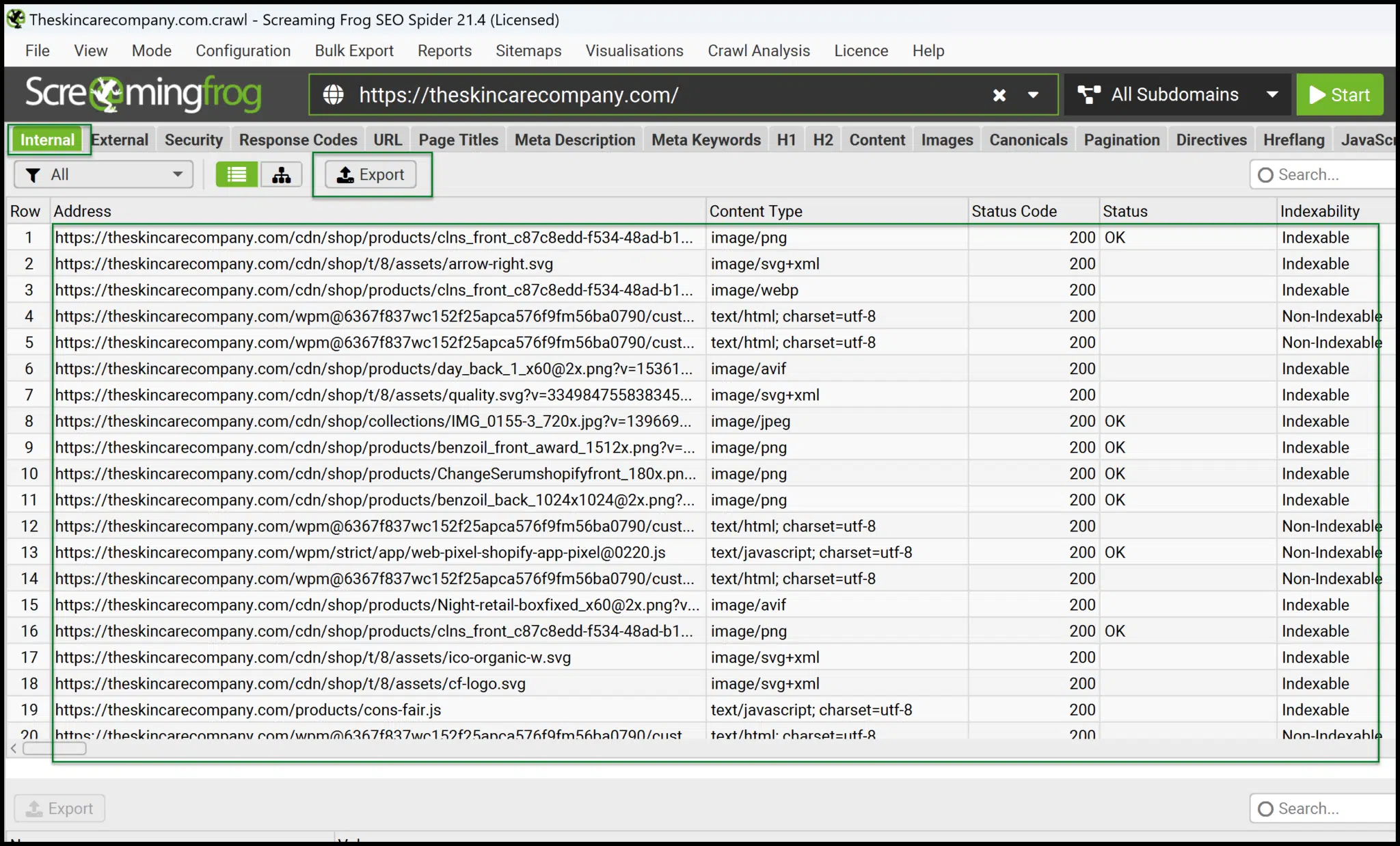

Screaming Frog — это настольное приложение, которое локально работает на вашем компьютере, чтобы генерировать данные сканирования для вашего веб -сайта.

Они также предлагают анализатор файла журнала, который полезен, если у вас есть доступ к файлам журнала сервера. На данный момент мы сосредоточимся на Seo Spider’s Seo Seo Screing Frog.

Составляет 259 долларов в год, он высоко экономически эффективен по сравнению с другими инструментами, которые взимают это много в месяц.

Однако, поскольку он работает локально, ползание останавливается, если вы выключите компьютер — он не работает в облаке.

Тем не менее, данные, которые он предоставляет, быстрые, точные и идеальные для тех, кто хочет глубже погрузиться в технический SEO.

Из основного интерфейса вы можете быстро запустить свои собственные полки.

После завершения, экспорт Внутренние> все данные к прочитаемому препарату формату и комфортно обработать и разворачивать данные для более глубокого понимания.

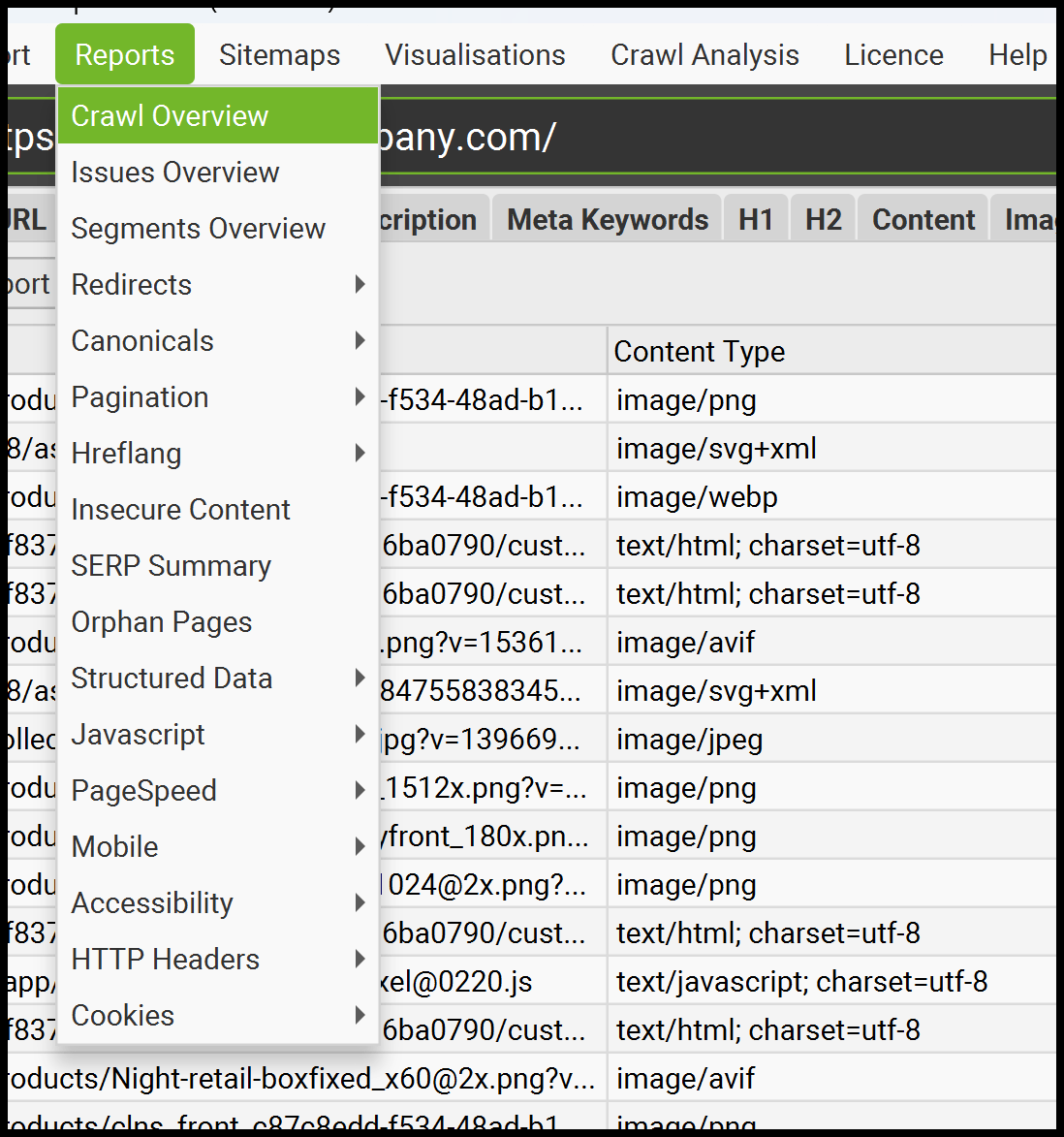

Screaming Frog также предлагает много других полезных вариантов экспорта.

Он предоставляет отчеты и экспорт для внутреннего связывания, перенаправления (включая перенаправление цепочки), небезопасное содержание (смешанный контент) и многое другое.

Недостатком является то, что требуется больше практического управления, и вам нужно будет чувствовать себя комфортно, работая с данными в Excel или Google Sheets, чтобы максимизировать ее значение.

Ты глубже: 4 лучших технических инструментов SEO

Аудит сайта Ahrefs

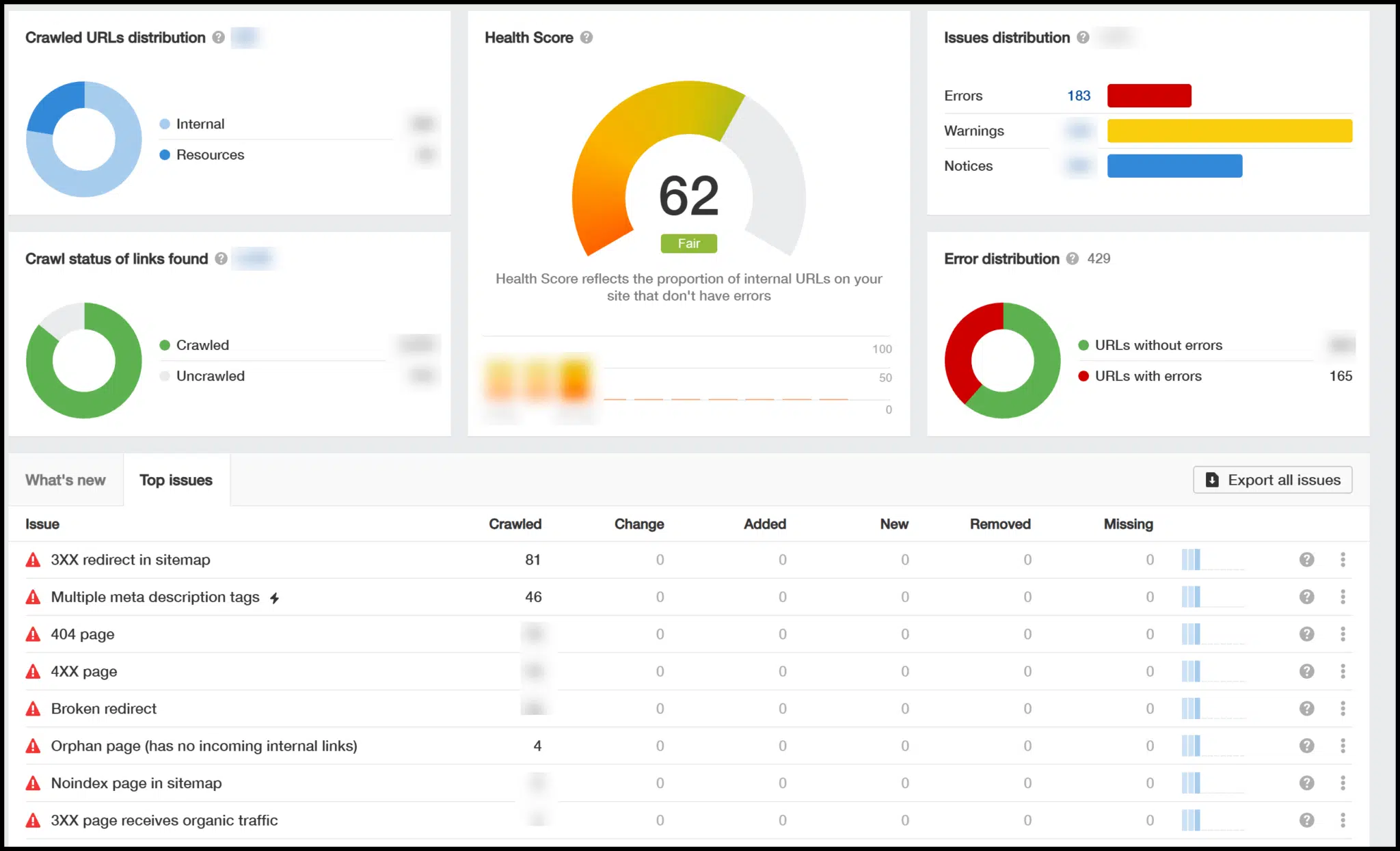

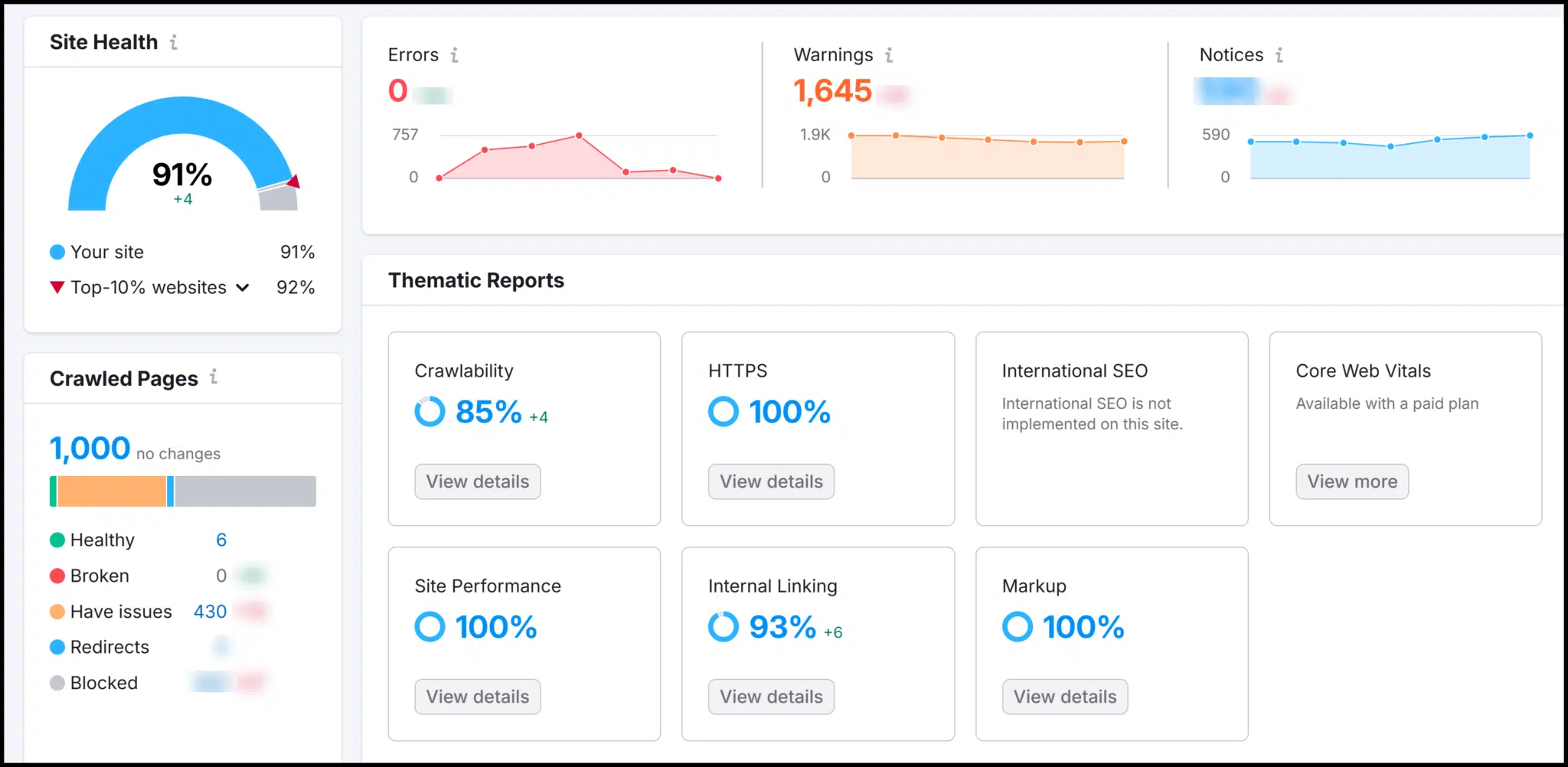

AHREFS-это всеобъемлющая облачная платформа, которая включает в себя технический SEO Crawler в модуле аудита сайта.

Чтобы использовать его, настройте проект, настройте параметры сканирования и запустите Crawl, чтобы создать технические представления SEO.

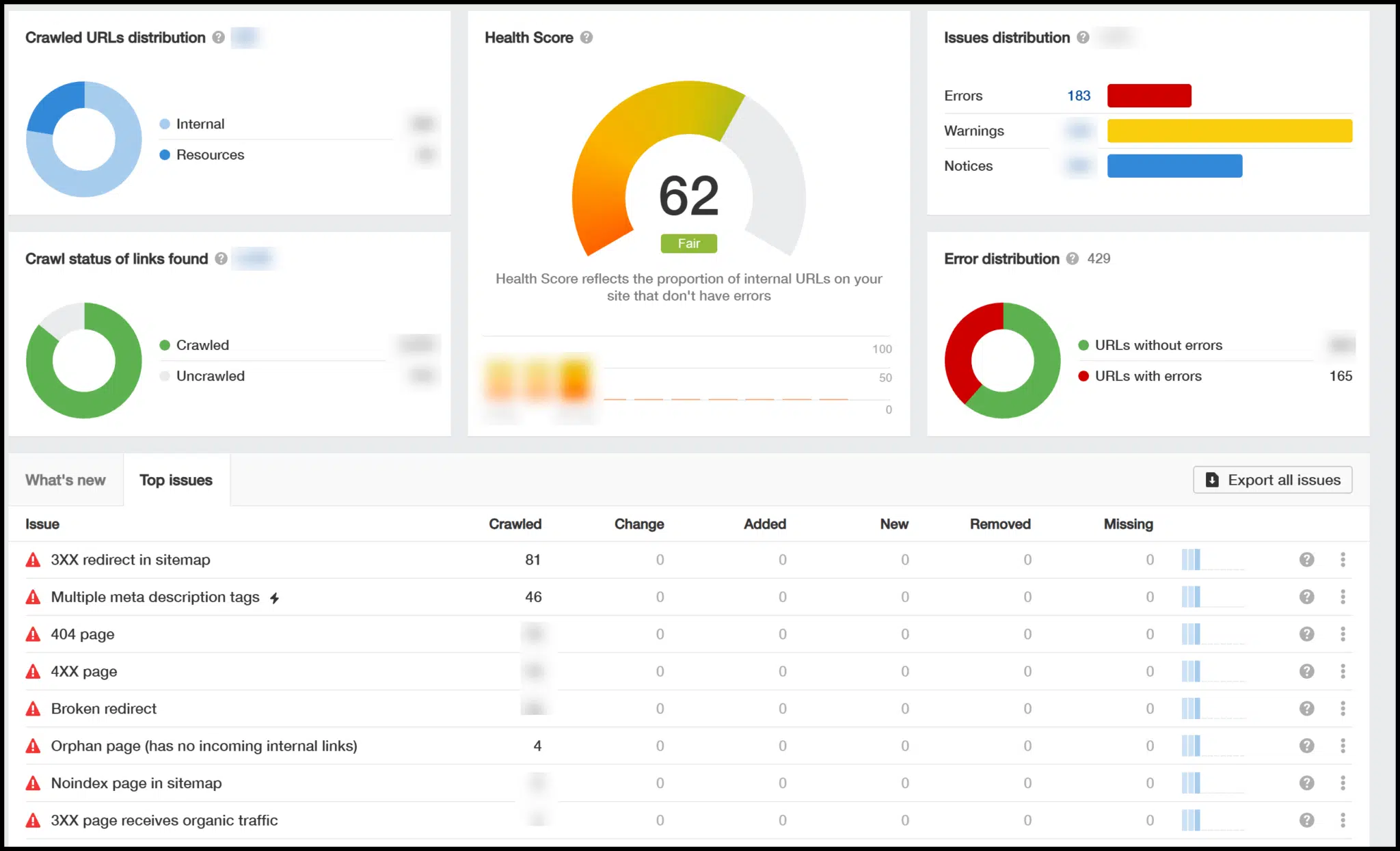

После завершения ползания вы увидите обзор, который включает в себя технический рейтинг здоровья SEO (0-100) и выделяет ключевые проблемы.

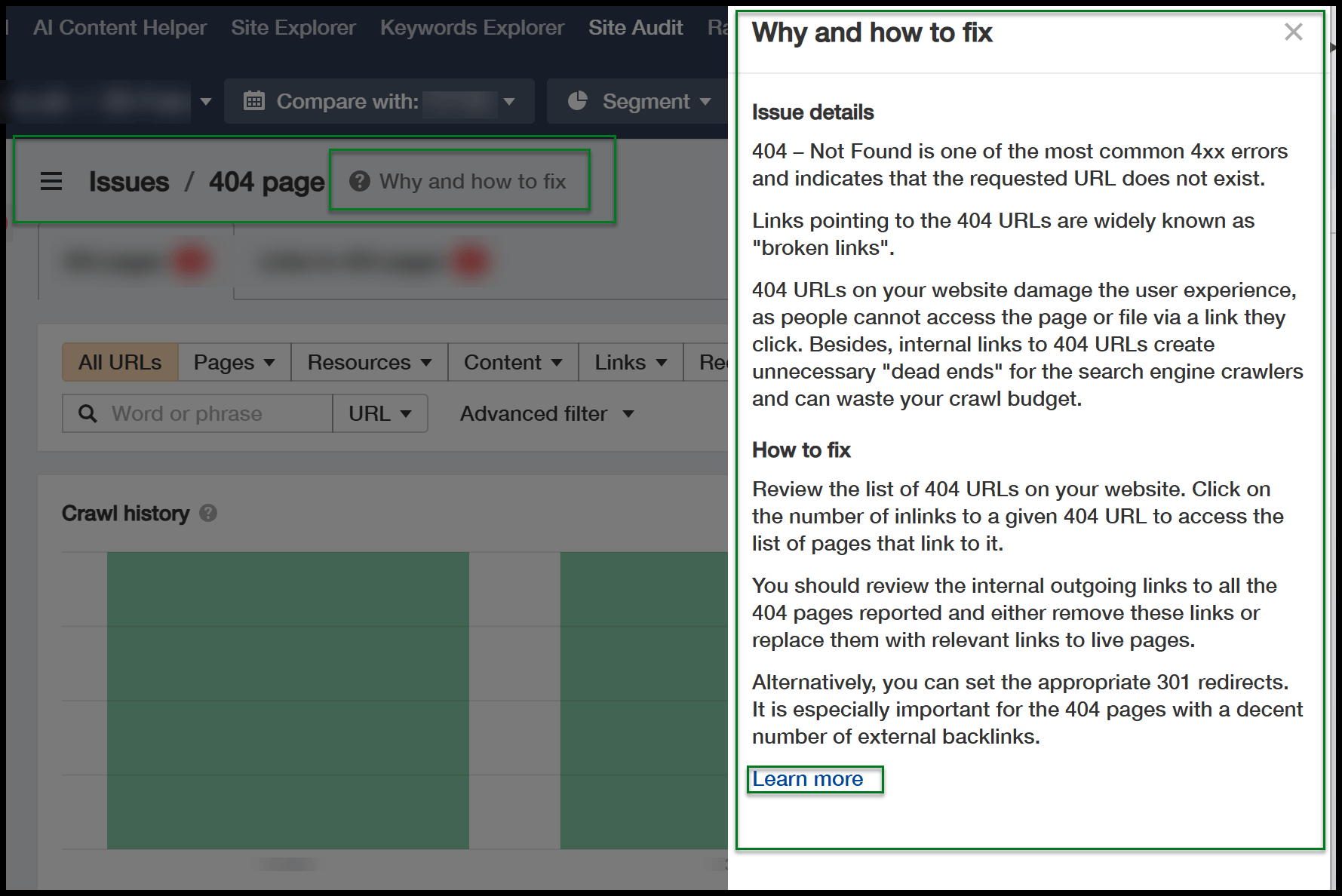

Вы можете нажать на эти проблемы для более подробной информации, и полезная кнопка появляется глубже, объясняя, почему необходимы определенные исправления.

Поскольку Ahrefs работает в облаке, статус вашей машины не влияет на ползание. Это продолжается, даже если ваш компьютер или Mac выключены.

По сравнению с кричащей лягушкой, Ahrefs обеспечивает больше рекомендаций, что облегчает превращение данных Crawl в действующие SEO Insights.

Тем не менее, это менее экономически эффективно. Если вам не нужны дополнительные функции, такие как данные обратной ссылки и исследования ключевых слов, это может не стоить затрат.

Semrush сайт аудит

Далее-Semrush, еще одна мощная облачная платформа со встроенным техническим SEO-Crawler.

Как и Ahrefs, он также обеспечивает анализ обратных ссылок и инструменты исследования ключевых слов.

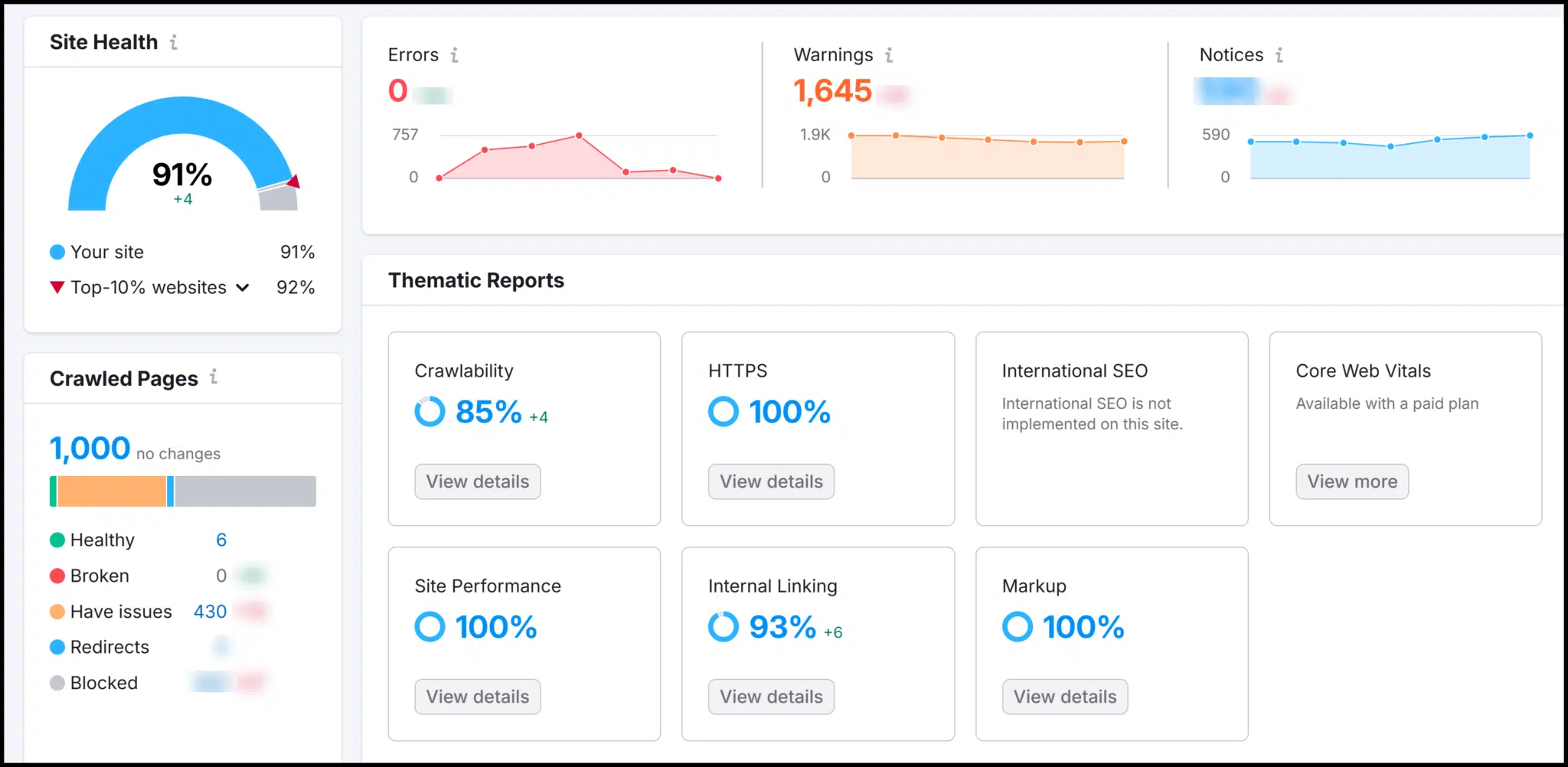

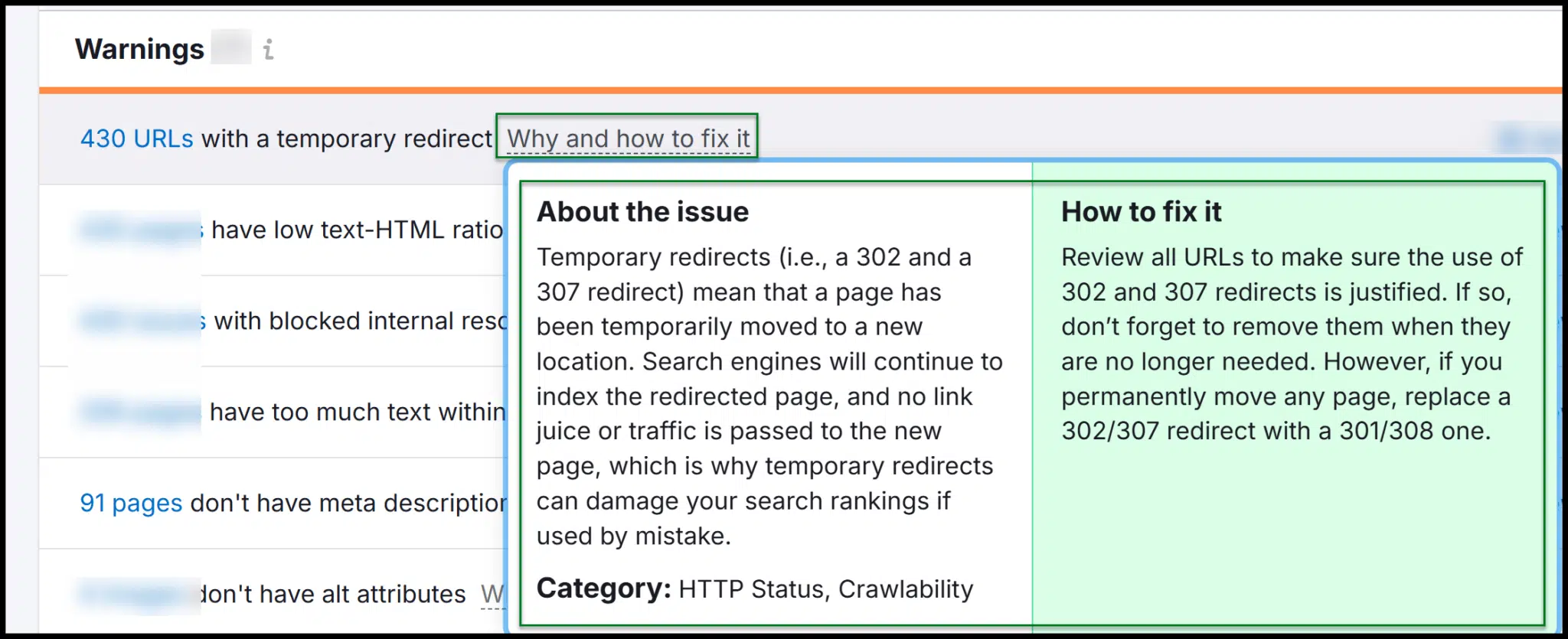

Semrush предлагает технический рейтинг Health SEO, который улучшается по мере исправления проблем с сайтами. Его обзор сканирования подчеркивает ошибки и предупреждения.

Когда вы исследуете, вы найдете объяснения, почему необходимы исправления и как их реализовать.

Как Semrush, так и Ahrefs имеют надежные инструменты аудита сайтов, что позволяет легко запустить Crawls, анализировать данные и предоставлять рекомендации разработчикам.

В то время как обе платформы дороже, чем кричащая лягушка, они преуспевают в том, чтобы превратить данные ползания в действие.

Semrush немного более рентабельный, чем Ahrefs, что делает его солидным выбором для тех, кто новичок в техническом SEO.

Получить маркетологи поиска в информационном бюллетене.

Сторонние сканеры: боты, которые могут посетить ваш сайт

Ранее мы обсуждали, как третьи стороны могут ползти на вашем веб -сайте по разным причинам.

Но что это за внешние сканеры и как вы можете их определить?

Googlebot

Как уже упоминалось, вы можете использовать Google Search Console для доступа к некоторым данным Crawl’s Googlebot для вашего сайта.

Без Googlebot, ползая на вашем сайте, не было бы никаких данных для анализа.

(Вы можете узнать больше о общих ботах Google для ползания в этом Поиск центральной документации.)

Самые распространенные сканеры Google:

- Googlebot смартфон.

- Настольный Googlebot.

Каждый использует отдельные двигатели рендеринга для мобильных и настольных компьютеров, но оба содержат «Googlebot/2.1В их строке пользователя-агента.

Если вы анализируете журналы сервера, вы можете выделить трафик Googlebot, чтобы увидеть, какие области вашего сайта он чаще всего ползет.

Это может помочь определить технические проблемы SEO, такие как страницы, которые Google не ползает, как и ожидалось.

Чтобы проанализировать файлы журнала, вы можете создать электронные таблицы для обработки и разбора данных из необработанных файлов .txt или .csv. Если это кажется сложным, анализатор журнала Screaming Frog является полезным инструментом.

В большинстве случаев вы не должны блокировать Googlebot, так как это может негативно повлиять на SEO.

Однако, если Googlebot застрял в высоко динамической архитектуре сайта, вам может потребоваться заблокировать определенные URL -адреса через robots.txt. Тщательно используйте это — чрезмерное использование может нанести вред вашему рейтингу.

Фальшивый трафик Googlebot

Не весь трафик, претендующий на то, чтобы быть Googlebot, является законным.

Многие скалеры и скребки позволяют пользователям обмениваться строками пользователя-агента, что означает, что они могут замаскировать себя как Googlebot, чтобы обойти ограничения для ползания.

Например, кричащая лягушка может быть настроена на выдачу Googlebot.

Тем не менее, многие веб -сайты, особенно те, которые размещены в больших облачных сетях, таких как AWS, могут различаться между реальным и фальшивым трафиком Googlebot.

Они делают это, проверяя, если запрос поступает из официальных диапазонов IP Google.

Если запрос претендует на Googlebot, но происходит за пределами этих диапазонов, это, вероятно, подделка.

Другие поисковые системы

В дополнение к Googlebot, другие поисковые системы могут ползти на вашем сайте. Например:

- Бингбот (Microsoft Bing).

- Duckduckbot (Duckduckgo).

- Yandexbot (Yandex, русская поисковая система, хотя и не хорошо документирована).

- Baiduspider (Байду, популярная поисковая система в Китае).

В вашем файле robots.txt вы можете создавать правила подстановочного знака для запрета всех поисковых ботов или указать правила для конкретных сканеров и каталогов.

Тем не менее, имейте в виду, что записи robots.txt являются директивами, а не командами, то есть их можно игнорировать.

В отличие от перенаправлений, которые предотвращают обслуживание сервера, Robots.txt — это просто сильный сигнал, с просящим ботов не ползать в определенных областях.

Некоторые скалеры могут полностью игнорировать эти директивы.

Кричащий бот лягушки

Кричащая лягушка обычно идентифицирует себя с помощью пользовательского агента, как Screaming Frog SEO Spider/21.4Полем

Текст «Screaming Frog Seo Spider» всегда включен, за которым следует номер версии.

Тем не менее, Screaming Frog позволяет пользователям настраивать строку пользователя-агента, что означает, что Crawls может показаться из Googlebot, Chrome или другого пользовательского агента.

Это затрудняет заблокирование кричащих лягушек.

В то время как вы можете блокировать пользовательские агенты, содержащие «Screaming Frog Seo Spider», оператор может просто изменить строку.

Если вы подозреваете несанкционированное ползание, вам может потребоваться идентифицировать и заблокировать диапазон IP.

Это требует вмешательства на стороне сервера от вашего веб-разработчика, так как robots.txt не может блокировать IPS-тем более, что Screaming Frog может быть настроена, чтобы игнорировать директивы robots.txt.

Будь осторожен, хотя. Это может быть ваша собственная команда SEO, проводящая ползулку, чтобы проверить наличие технических проблем SEO.

Прежде чем блокировать кричащую лягушку, попробуйте определить источник трафика, так как это может быть внутренний сотрудник, собирающий данные.

Ahrefs Bot

У Ahrefs есть бот для ползания для ползания.

- Когда Ahrefs ползет в Интернете по собственному индексу, вы увидите трафик от

AhrefsBot/7.0Полем - Когда пользователь AHREFS проводит аудит сайта, трафик будет отключен

AhrefsSiteAudit/6.1Полем

Оба бота уважают роботы.

Если вы не хотите, чтобы ваш сайт был заполнен, вы можете блокировать ahrefs с помощью robots.txt.

В качестве альтернативы, ваш веб -разработчик может отрицать запросы от пользовательских агентов, содержащих »«AhrefsBot» или «AhrefsSiteAudit«

Semrush Bot

Как и Ahrefs, Semrush управляет несколькими сканерами с различными строками пользователя-агента.

Обязательно просмотрите всю доступную информацию, чтобы правильно их определить.

Две наиболее распространенные строки пользователя-агента, с которыми вы столкнетесь,-это:

- Semrushbot: General Web Crawler Semrush, используемый для улучшения своего индекса.

- Siteauditbot: Используется, когда пользователь Semrush инициирует аудит сайта.

Rogerbot, Dotbot и другие сканеры

MOZ, еще одна широко используемая облачная платформа SEO, развертывает Rogerbot для ползания веб-сайтов для технической информации.

Моз также управляет Dotbot, общим веб -гусеницей. Оба могут быть заблокированы через ваш файл robots.txt, если это необходимо.

Еще один густо, с которым вы можете столкнуться, — MJ12BOT, используемый Majestic SEO -платформой. Как правило, не о чем беспокоиться.

Неайо-ползание боты

Не все скалеры связаны с SEO. Многие социальные платформы управляют собственными ботами.

Meta (материнская компания Facebook) запускает несколько сканеров, в то время как Twitter ранее использовал Twitterbot-и, вероятно, X теперь использует аналогичную, хотя и менее документированную систему.

Ползание непрерывно сканирует сеть на предмет данных. Некоторые могут принести пользу вашему сайту, в то время как другие должны контролироваться с помощью журналов сервера.

Понимание поисковых ботов, сканеров SEO и скребков для технического SEO

Управление как первыми, так и сторонними сканерами необходимо для поддержания технического SEO вашего сайта.

Ключевые выводы

- Первозависимые сканеры (Например, кричащая лягушка, ахрефы, semrush) Помогите аудить и оптимизировать свой собственный сайт.

- Googlebot Insights через поисковую консоль предоставляет важные данные об индексации и производительности.

- Сторонние сканеры (Например, Bingbot, Ahrefsbot, Semrushbot) Crawl Your Sate для поиска индексации или конкурентного анализа.

- Управление ботами через robots.txt и серверные журналы могут помочь контролировать нежелательные сканеры и повысить эффективность сканирования в определенных случаях.

- Навыки обработки данных имеют решающее значение для извлечения значимой информации из отчетов Crawl и файлов журналов.

Сбалансируя упреждающий аудит со стратегическим управлением ботами, вы можете гарантировать, что ваш сайт остается хорошо оптимизированным и эффективным заполненным.

Авторы, способствующие созданию контента, для поисковых земель и выбираются для их опыта и вклада в поисковое сообщество. Наши участники работают под надзором редакционного персонала, а взносы проверены на качество и актуальность для наших читателей. Мнения, которые они выражают, являются их собственными.