В последнее время вы немного погуглили, чтобы встретить милый маленький логотип алмаза о некоторых волшебных расслабляющих словах? Обзор ИИ от Google объединяет языковые модели Google Gemini (которые генерируют ответы) с генерацией доступа, которая снижает соответствующую информацию.

Теоретически, он сделал невероятный продукт, поисковую систему Google, еще проще и быстрее.

Однако, поскольку создание этих резюме является двухэтапным процессом, проблемы могут возникнуть, если существует разделение между доступом и генерацией языка.

В то время как вызванная информация может быть правильной, ИИ может нарисовать неисправные прыжки и делать странные выводы при генерации резюме.

Это привело к некоторым знаменитым оплошникам, например, когда в середине -2024 он стал смехом материала Интернета, чтобы порекомендовать клей, чтобы убедиться, что сыр не проскальзывает их домашняя пицца. И нам понравилось время, в течение которого оно было описано, чтобы работать с ножницами как «кардио упражнения, которые улучшают их частоту сердечных сокращений и требуют концентрации и сосредоточения».

Это инициировала Лиз Рейд, глава Google Search, статья под названием «С названием» За прошедшую неделюПоказание этих примеров «подчеркивало некоторые конкретные области, которые мы должны были улучшить». Кроме того, она дипломатически обвинила «бессмысленные запросы» и «сатирический контент».

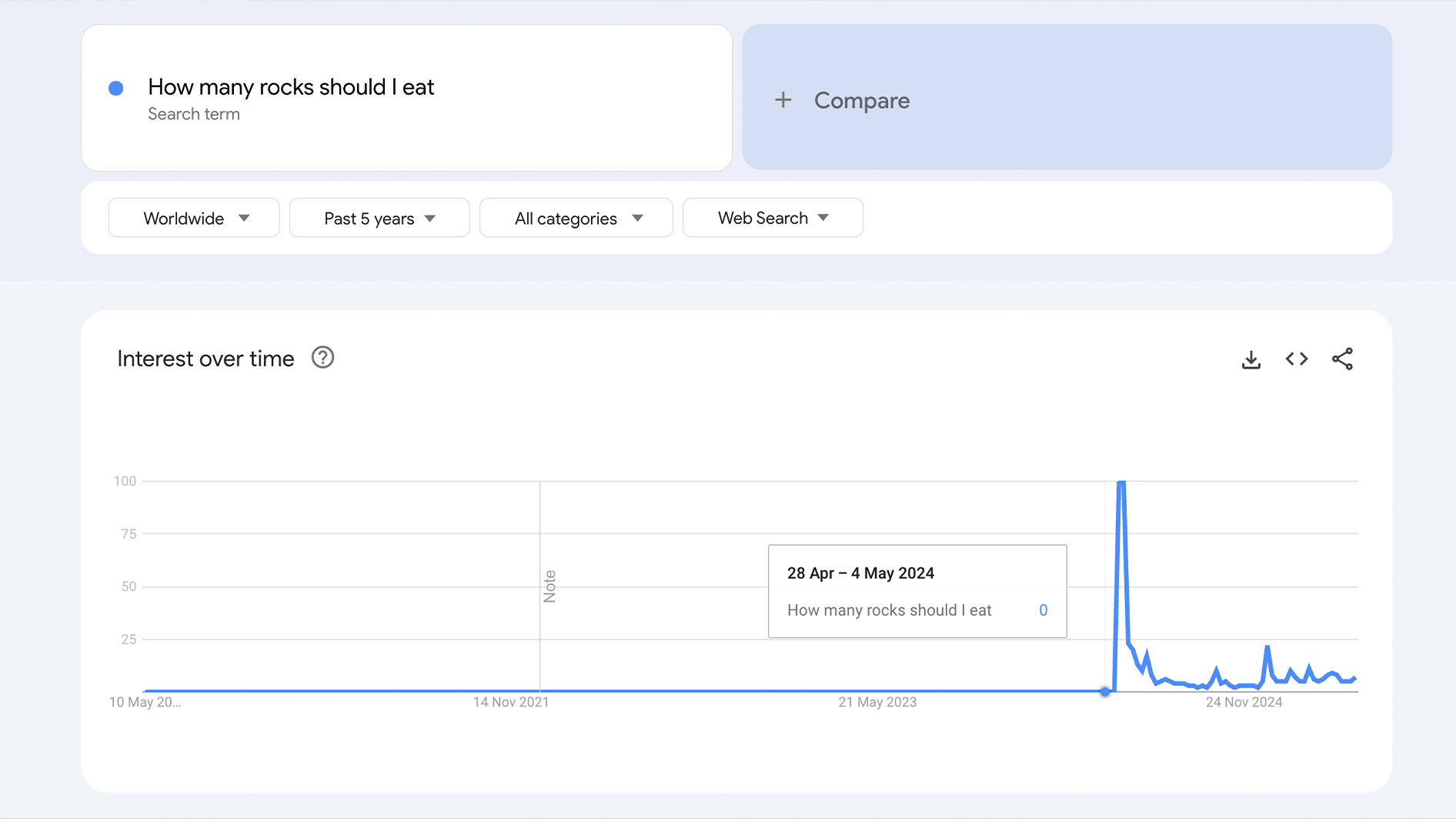

По крайней мере, частично она была права. Некоторые из проблемных запросов были подчеркнуты только в интересах, чтобы ИИ выглядел глупым. Как вы можете видеть ниже: «Сколько камней мне нужно есть?» Не был частым поиском до введения обзоров ИИ, и с тех пор этого не было.

Спустя почти год после фиаско Pizza Glue люди по-прежнему являются обзором ИИ производства информации или «галлюцинирования»-эвфемизма для ИИ.

Многие вводящие в заблуждение запросы, похоже, игнорируются, чтобы написать, но это было только в прошлом месяце Сообщает Engadget Что обзоры ИИ для идиомов, таких как «Ты не можешь жениться на пицце» или «никогда не сделает ноутбук Бассета».

Таким образом, ИИ часто неправ, если вы сознательно обманывают его. Большое это. Но теперь, когда он используется миллиардами и включает в себя медицинские советы, что происходит, когда реальный вопрос ведет к галлюцинации?

В то время как ИИ работает чудесно, когда каждый, кто его использует, изучает, откуда полученная их информация, многие люди — если не большинство людей — не будут.

И это ключевая проблема. Как писатель, обзоры уже немного раздражают, потому что я хочу прочитать, пишущий человеческий контент. Но даже если я откладываю свой прожирский предвзятость в сторону, ИИ становится серьезно проблематичным, если он так легко не заслуживает доверия. И теперь, вероятно, опасно, что поиск в основном вездесущен, и определенная часть пользователя будет записывать свою информацию о номинальном значении.

Я имею в виду, поиск много лет поиска нас всех, чтобы доверять результатам в верхней части страницы.

Содержание

Подожди … это правда?

Сколько людей я могу иногда бороться с изменениями. Мне это не понравилось, когда Леброн отправился в «Лейкерс», и я слишком долго оставался на iPod с MP3 -плеером.

Ввиду того факта, что сейчас это первое, что вы видите большую часть времени в Google, обзоры ИИ Google несколько сложнее игнорировать.

Я пытался использовать его как Википедия — потенциально ненадежная, но полезно помнить забытую информацию или изучить основы темы, которая не вызывает агиты, если она не на 100%.

Но даже с явно простыми вопросами это может эффектно провалиться. Например, я видел фильм и этот парень Действительно выглядел как Лин-Мануэль Миранда (создатель мюзикла Гамильтон), Поэтому я гуглил, были ли у него братья.

Обзор ИИ сообщил мне: «Да, у Лин-Мануэля Миранда два младших брата по имени Себастьян и Франциско».

В течение нескольких минут я думал, что я гений в признании людей … пока немного дальнейших осмотров не показали, что Себастьян и Франциско на самом деле были двумя детьми.

Я хотел дать ему преимущество сомнения и встало, что не будет никаких проблем с списком цитат из «Звездных войн», чтобы помочь мне подумать о заголовке.

К счастью, это дало мне именно то, что мне нужно. «Привет!» И «Это ловушка!», И даже цитируется «нет, я твой отец», в отличие от вообще повторяемого «Люк, я твой отец».

Вместе с этими законными цитатами Анакин заявил: «Когда я ухожу, я иду с ударом», прежде чем быть преобразованным в Дарта Вейдера.

Я был шокирован тем, как это могло быть неправильно … а потом я начал беспокоиться. Я думаю, что я должен ошибаться. Я был так не уверен, что проверил существование тройной цитаты И Он был поделился с офисом — где он был быстро (и правильно) в качестве дальнейшей атаки AI Lunacy.

Этот маленький кусочек себя -о чем -то столь же глупых, как «Звездные войны», напугал меня. Что если бы я не знал по теме, о которой я спросил?

Это исследование Рейтинг фактически показывает обзоры ИИ Google, избегает (или тщательно реагирует на) такие темы, как финансы, политика, здоровье и право. Это означает Google белый То, что его ИИ еще не выросла задачу более серьезных вопросов.

Но что происходит, когда Google считает, что он улучшается до сих пор, что может?

Это технология … но также и то, как мы ее используем

Если бы каждый, кто мог бы использовать Google, могли бы быть заслуживающим доверия, чтобы проверить результаты ИИ или нажать на исходные ссылки, предоставленные обзором, их неточности не будут проблемой.

Но до тех пор, пока есть более простой вариант — более гладкий путь — люди, как правило, принимают его.

Несмотря на то, что у нас есть больше информации о кончиках пальцев, чем в любое более раннее в истории человечества, наши страны во многих странах Лотерезация и растворители уменьшаютсяПолем Типичный пример показал исследование с 2022 года, что это только справедливо 48,5% американцев утверждают, что они прочитали, по крайней мере, один Забронируйте за последние 12 месяцевПолем

Это не сама технология, которая является проблемой. Как это красноречиво утверждается доцентом Грантом БлашкиТо, как мы используем технологию (и, действительно, то, как мы контролируемся в использовании ее), находится там, где возникают проблемы.

Например Наблюдательное исследование исследователей в Канадском университете Макгилла обнаружил, что регулярное использование GPS может привести к ухудшению пространственной памяти — и не может перемещаться в одиночку. Я не могу быть единственным, кто использовал карты Google, чтобы куда -то добраться, и понятия не имел, как вернуться.

Нейронауки ясно показали, что борьба хороша Для мозга. Теория когнитивной нагрузки объясняет, что ваш мозг должен думать узнать о вещах. Трудно представить, что ему есть слишком много, чтобы сражаться, если вы ищете вопрос, прочитайте резюме ИИ, а затем назовите вас на один день.

Решить подумать

Я не обязался никогда больше не использовать GPS, но, поскольку обзоры Google ИИ не заслуживают доверия, я бы избавился от обзоров ИИ, если бы мог. К сожалению, на данный момент нет такого метода.

Даже взломы, такие как добавление руганого слова к вашему запросу, больше не работают. (И хотя использование F-Word все еще работает большую часть времени, это также гарантирует незнакомца и многое другое, «ориентированные на оси» результаты поиска, которые вы, вероятно, не ищете.)

Конечно, я все равно буду использовать Google — потому что это Google. Это не приведет к его амбициям в области искусственного интеллекта, и хотя я хотел бы восстановить возможность отключить обзоры ИИ, это может быть лучше дьяволом, которого ты знаешь.

На данный момент единственная истинная защита против формирования вражды AI — это приложить согласованные усилия, чтобы не использовать их. Позвольте себе сделать заметки о ваших рабочих собраниях или нескольких закупленных частях, но когда речь заходит о том, чтобы использовать вас в качестве источника информации, я проведу его и высококачественные, написанные (или, по крайней мере, проверенные) статьи из лучших результатов, и я сделал это почти для всех моего существования.

Ранее я упоминал, что эти инструменты искусственного интеллекта действительно могут стать надежным источником информации однажды. Вы могли бы даже быть достаточно умным, чтобы принять политику. Но этот день не сегодня.

Действительно, как Отчеты 5 мая New York TimesПоскольку инструменты AI Google и Chatgpt становятся сильнее, они всегда становятся ненадежными — поэтому я не уверен, буду ли я когда -либо доверять им, чтобы они суммировали политику политического кандидата.

При тестировании уровня галлюцинации этих «аргументационных систем» самый высокий уровень галлюцинации составил 79%. AMR Awadalla, управляющий директор Vectara — агента по искусственному интеллекту и платформу помощи для компаний — прямо приостановил: «Несмотря на наши усилия, вы всегда галлюцинируете».