Интернет — это постоянно развивающаяся виртуальная вселенная, насчитывающая более 1,1 миллиарда веб-сайтов.

Как вы думаете, может ли Google просканировать каждый веб-сайт в мире?

Даже со всеми ресурсами, деньгами и центрами обработки данных, которые есть у Google, он даже не может просканировать всю сеть — да и не хочет.

Содержание

- 1 Что такое краулинговый бюджет и насколько он важен?

- 2 1. Определите, какие страницы важны, а какие не следует сканировать

- 3 2. Управляйте дублирующимся контентом

- 4 3. Заблокируйте сканирование неважных URL-адресов с помощью robots.txt и сообщите Google, какие страницы он может сканировать

- 5 4. Длинные цепочки перенаправлений

- 6 5. Используйте HTML

- 7 6. Убедитесь, что ваши веб-страницы загружаются быстро и предлагают хороший пользовательский интерфейс

- 8 7. Имейте полезный контент

- 9 8. Следите за ошибками сканирования

- 10 9. Поддерживайте актуальность файлов Sitemap

- 11 10. Создайте хорошую структуру сайта

- 12 11. Внутренние ссылки

- 13 12. Всегда отслеживайте статистику сканирования

- 14 Подведение итогов

Что такое краулинговый бюджет и насколько он важен?

Бюджет сканирования — это количество времени и ресурсов, которое робот Googlebot тратит на сканирование веб-страниц в домене.

Важно оптимизировать ваш сайт, чтобы Google быстрее находил ваш контент и индексировал его, что могло бы помочь вашему сайту повысить видимость и трафик.

Если у вас большой сайт с миллионами веб-страниц, особенно важно управлять краулинговым бюджетом, чтобы помочь Google просканировать самые важные страницы и лучше понять ваш контент.

Гугл утверждает, что:

Если на вашем сайте не так много страниц, которые быстро меняются, или если кажется, что ваши страницы сканируются в тот же день, когда они опубликованы, поддержание вашей карты сайта в актуальном состоянии и проверка покрытия вашего индекса достаточно регулярно. Google также заявляет, что каждая страница должна быть просмотрена, объединена и оценена, чтобы определить, где она будет проиндексирована после сканирования.

Бюджет сканирования определяется двумя основными элементами: ограничением емкости сканирования и потребностью в сканировании.

Спрос на сканирование — это то, сколько Google хочет сканировать ваш сайт. Более популярные страницы, т. е. популярный сюжет CNN и страницы со значительными изменениями, будут сканироваться чаще.

Робот Googlebot хочет просканировать ваш сайт, не перегружая ваши серверы. Чтобы предотвратить это, робот Googlebot вычисляет предел мощности сканирования, который представляет собой максимальное количество одновременных параллельных подключений, которые робот Googlebot может использовать для сканирования сайта, а также временную задержку между выборками.

Принимая во внимание объем сканирования и потребность в сканировании, Google определяет краулинговый бюджет сайта как набор URL-адресов, которые робот Googlebot может и хочет сканировать. Даже если лимит сканирования не достигнут, если потребность в сканировании низкая, робот Googlebot будет сканировать ваш сайт меньше.

Вот 12 лучших советов по управлению краулинговым бюджетом для крупных и средних сайтов с количеством URL-адресов от 10 000 до миллионов.

1. Определите, какие страницы важны, а какие не следует сканировать

Определите, какие страницы важны, а какие не так важны для сканирования (и, таким образом, Google посещает их реже).

Как только вы определите это с помощью анализа, вы сможете увидеть, какие страницы вашего сайта стоит сканировать, а какие страницы вашего сайта не стоит сканировать, и исключить их из сканирования.

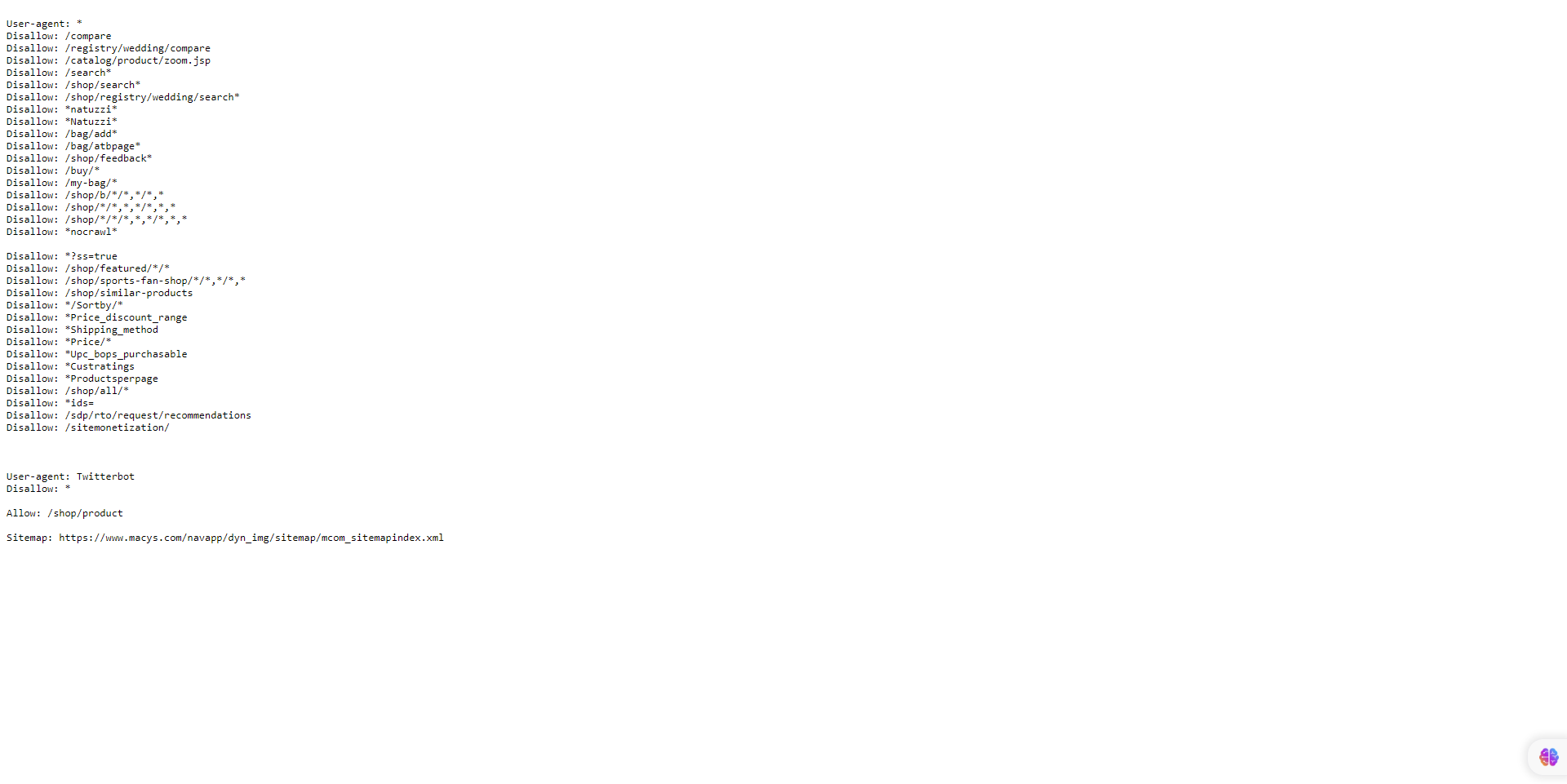

Например, Macys.com имеет более 2 миллионов проиндексированных страниц.

Он управляет своим краулинговым бюджетом, информируя Google о том, что не следует сканировать определенные страницы сайта, поскольку он запретил роботу Googlebot сканировать определенные URL-адреса в файле robots.txt.

Робот Googlebot может решить, что не стоит тратить время на просмотр остальной части вашего сайта или увеличивать краулинговый бюджет. Убедись в том, что Граненый навигация и идентификаторы сеанса: заблокированы через robots.txt

2. Управляйте дублирующимся контентом

Хотя Google не наказывает за дублирование контента, вы хотите предоставить роботу Googlebot оригинальную и уникальную информацию, которая удовлетворяет информационные потребности конечного пользователя, является актуальной и полезной. Убедитесь, что вы используете файл robots.txt.

Google заявил, что не использует индекс, так как он все равно будет запрашивать, но затем откажется.

3. Заблокируйте сканирование неважных URL-адресов с помощью robots.txt и сообщите Google, какие страницы он может сканировать

Для сайта корпоративного уровня с миллионами страниц Google рекомендует блокировать сканирование неважных URL-адресов с помощью файла robots.txt.

Кроме того, вы хотите убедиться, что ваши важные страницы, каталоги, содержащие ваш золотой контент, и финансовые страницы разрешены для сканирования роботом Googlebot и другими поисковыми системами.

Скриншот от автора, июнь 2023 г.

Скриншот от автора, июнь 2023 г.4. Длинные цепочки перенаправлений

Сократите количество переадресаций до небольшого числа, если можете. Слишком большое количество переадресаций или циклов переадресации может запутать Google и снизить лимит сканирования.

Google утверждает, что длинные цепочки перенаправлений могут негативно сказаться на сканировании.

5. Используйте HTML

Использование HTML увеличивает вероятность того, что сканер из любой поисковой системы посетит ваш сайт.

В то время как Googlebots улучшили сканирование и индексирование JavaScript, другие поисковые роботы не так сложны, как Google, и могут иметь проблемы с другими языками, кроме HTML.

6. Убедитесь, что ваши веб-страницы загружаются быстро и предлагают хороший пользовательский интерфейс

Сделайте свой сайт оптимизированным для Core Web Vitals.

Чем быстрее загружается ваш контент, т. е. менее чем за три секунды, тем быстрее Google может предоставить информацию конечным пользователям. Если им это понравится, Google продолжит индексировать ваш контент, потому что ваш сайт продемонстрирует работоспособность сканирования Google, что может привести к увеличению вашего лимита сканирования.

7. Имейте полезный контент

По данным Google, контент оценивается по качеству независимо от возраста. Создавайте и обновляйте свой контент по мере необходимости, но нет никакой дополнительной ценности в том, чтобы страницы искусственно выглядели свежими, внося тривиальные изменения и обновляя дату страницы.

Если ваш контент удовлетворяет потребности конечных пользователей и, т. е. полезен и актуален, не имеет значения, старый он или новый.

Если пользователи не находят ваш контент полезным и актуальным, я рекомендую вам обновлять и обновлять свой контент, чтобы он был свежим, актуальным и полезным, и продвигать его через социальные сети.

Кроме того, свяжите свои страницы напрямую с главной страницей, которая может рассматриваться как более важная и сканироваться чаще.

8. Следите за ошибками сканирования

Если вы удалили несколько страниц на своем сайте, убедитесь, что URL-адрес возвращает статус 404 или 410 для окончательно удаленных страниц. Код состояния 404 — сильный сигнал не сканировать этот URL снова.

Однако заблокированные URL-адреса будут оставаться в очереди сканирования намного дольше и будут сканироваться повторно после снятия блокировки.

- Кроме того, Google заявляет об удалении всех программных страниц 404., которые будут продолжать сканироваться и тратить ваш краулинговый бюджет. Чтобы проверить это, войдите в GSC и просмотрите свой Отчет о покрытии индекса для программных ошибок 404.

Если на вашем сайте много 5xx коды состояния ответа HTTP (ошибки сервера) или тайм-ауты соединения сигнализируют об обратном, сканирование замедляется. Google рекомендует обратить внимание на отчет Crawl Stats в Search Console и свести количество ошибок сервера к минимуму.

Кстати, Google не соблюдает и не придерживается нестандартного правила robots.txt «задержка сканирования».

Даже если вы используете атрибут nofollow, страница все равно может быть просканирована и потрачена впустую краулинговый бюджет, если другая страница на вашем сайте или любая страница в Интернете не помечает ссылку как nofollow.

9. Поддерживайте актуальность файлов Sitemap

XML-карты сайта важны для того, чтобы помочь Google найти ваш контент и ускорить работу.

Чрезвычайно важно обновлять URL-адреса вашей карты сайта, использовать тег

- Включайте только URL-адреса, которые вы хотите проиндексировать поисковыми системами.

- Включайте только те URL-адреса, которые возвращают код статуса 200.

- Убедитесь, что размер одного файла карты сайта не превышает 50 МБ или 50 000 URL-адресов, а если вы решите использовать несколько карт сайта, создайте индексировать карту сайта который будет перечислять их все.

- Убедитесь, что ваша карта сайта Кодировка UTF-8.

- Включать ссылки на локализованные версии каждого URL. (Видеть документация от Google.)

- Поддерживайте свою карту сайта в актуальном состоянии, т. е. обновляйте карту сайта. каждый раз, когда появляется новый URL-адрес или старый URL-адрес обновляется или удаляется.

10. Создайте хорошую структуру сайта

Наличие хорошей структуры сайта важно для вашей эффективности SEO для индексации и взаимодействия с пользователем.

Структура сайта может влиять на результаты страниц результатов поисковой системы (SERP) несколькими способами, включая возможность сканирования, рейтинг кликов и взаимодействие с пользователем.

Наличие четкой и линейной структуры вашего сайта может эффективно использовать ваш краулинговый бюджет, что поможет роботу Googlebot находить любой новый или обновленный контент.

Всегда помните правило трех кликов, т. е. любой пользователь должен иметь возможность перейти с любой страницы вашего сайта на другую максимум за три клика.

11. Внутренние ссылки

Чем проще вы сделаете поисковым системам сканирование и навигацию по вашему сайту, тем легче поисковые роботы смогут идентифицировать вашу структуру, контекст и важный контент.

Наличие внутренних ссылок, указывающих на веб-страницу, может информировать Google о том, что эта страница важна, помогает установить информационную иерархию для данного веб-сайта и может способствовать распространению ссылочного веса на вашем сайте.

12. Всегда отслеживайте статистику сканирования

Всегда просматривайте и отслеживайте GSC, чтобы увидеть, есть ли какие-либо проблемы во время сканирования вашего сайта, и ищите способы сделать сканирование более эффективным.

Вы можете использовать Отчет о сканировании чтобы узнать, есть ли у робота Googlebot проблемы со сканированием вашего сайта.

Если в GSC для вашего сайта сообщается об ошибках доступности или предупреждениях, найдите экземпляры в доступность хоста графики, где запросы робота Googlebot превышают красную ограничительную линию, нажмите на график, чтобы увидеть, какие URL-адреса не работают, и попытайтесь сопоставить их с проблемами на вашем сайте.

Кроме того, вы можете использовать Инструмент проверки URL чтобы проверить несколько URL-адресов на вашем сайте.

Если инструмент проверки URL-адресов возвращает предупреждения о нагрузке на хост, это означает, что робот Googlebot не может просканировать столько URL-адресов с вашего сайта, сколько он обнаружил.

Подведение итогов

Оптимизация краулингового бюджета имеет решающее значение для крупных сайтов из-за их большого размера и сложности.

С многочисленными страницами и динамическим содержимым сканеры поисковых систем сталкиваются с трудностями при эффективном и действенном сканировании и индексировании содержимого сайта.

Оптимизируя краулинговый бюджет, владельцы сайтов могут расставить приоритеты при сканировании и индексировании важных и обновленных страниц, чтобы поисковые системы расходовали свои ресурсы разумно и эффективно.

Этот процесс оптимизации включает в себя такие методы, как улучшение архитектуры сайта, управление параметрами URL-адресов, установка приоритетов сканирования и устранение дублированного контента, что приводит к лучшей видимости в поисковых системах, улучшению взаимодействия с пользователем и увеличению органического трафика для крупных веб-сайтов.

Дополнительные ресурсы:

Рекомендуемое изображение: BestForBest/Shutterstock