Службы конкурентной разведки позволяют вам точно узнать, как работает веб-сайт.

Полученные данные помогают конкурентам обогнать своих соперников в результатах поиска.

Как скрыть ценную информацию от конкурентов? Разбираем самый эффективный метод, с помощью которого конкуренты больше не смогут анализировать ваш сайт.

Содержание

1 – Цель: Зачем запрещать роботам доступ к сайту?

Службы конкурентной разведки позволяют вам загружать ценную информацию о вашем веб-сайте. Полезная информация включает в себя: структуру страницы, внешние ссылки, текстовый контент и т. д.

Большинство предложений на рынке рекламных услуг основаны на имитации стратегий поисковых лидеров.

Работа состоит из простых шагов:

- Поиск конкурентов. Например, воспользуйтесь сервисом поиска конкурентов MegaIndex.

- Загрузка ценных данных через конкурирующие веб-сайты;

- Копирование решений.

Рекомендуемый материал в блоге MegaIndex по ссылке — Поиск конкурентов по ключевым словам. Бесплатно. Как его найти и почему.

Ценные данные включают в себя:

- Внешние ссылки из частной сети веб-сайтов;

- структура сайта;

- Контент, связанный с заголовками, h1-h6, фрагментами и основным контентом страницы.

Данные внешних ссылок можно найти через службу внешних ссылок MegaIndex.

Копирование успешных стратегий — действительно эффективное решение.

Есть несколько способов скрыть свой сайт от служб конкурентной разведки.

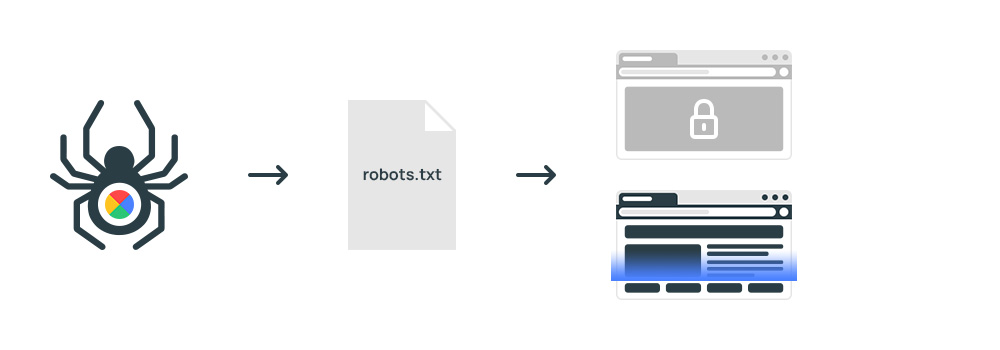

Наименее эффективный — это бан в файле robots.txt.

Директива robots.txt является рекомендацией и без правил. Авторитетные сервисы, такие как MegaIndex, учитывают рекомендации. Однако файл robots.txt не является гарантией того, что сайт не будет сканироваться другими сервисами.

Действенный способ — бан на уровне сервера. Пример кода можно найти по следующей ссылке: Запретить сканирование сайта на уровне сервера.

Идея правильная, но метод не идеален.

2 – Проблема: Как роботы сканируют сайты и обходят баны?

При обращении к сайту на сервер отправляется запрос с информацией о клиенте. Звонки записываются в журнал посещений, так называемый файл Протоколы. В лог-файле хранится информация обо всех посещениях сайта.

Каждая строка содержит Пользовательский агента также ИП.

Поисковые системы представлены следующим образом:

- Googlebot;

- Яндекс*. Например, Яндексбот, ЯндексКалендарь, ЯндексМобильныйБот.

Например, услуги представлены аналогично МегаИндексБот.

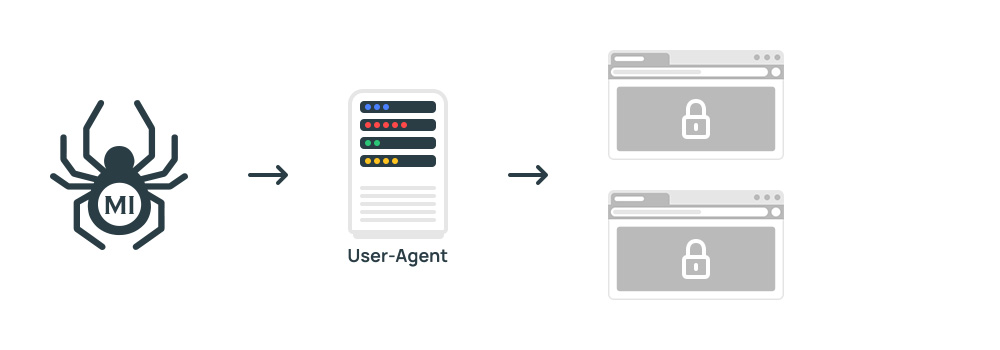

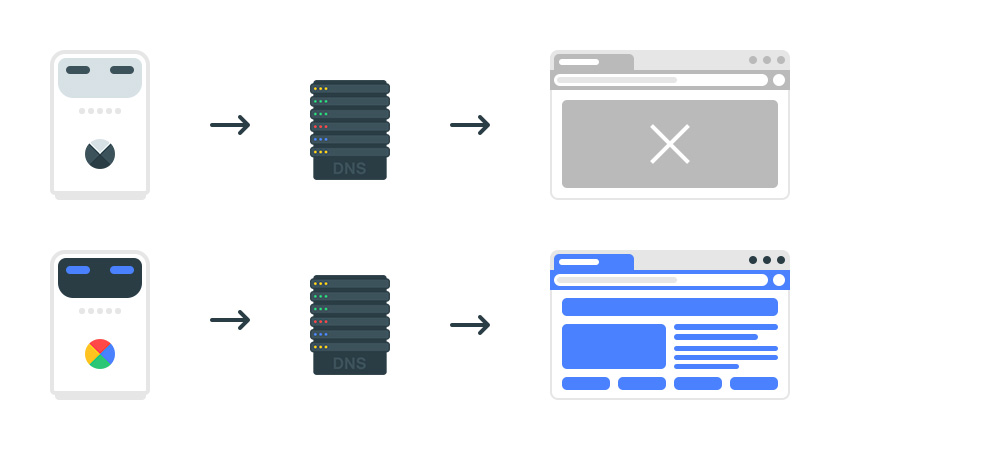

Скрипт блокировки на уровне сервера отклоняет запросы по списку значений Пользовательский агент.

Робот системы конкурентной разведки заблокирован. Но обойти защиту несложно. Например, представьте себе краулера вроде Yandexbot или Googlebot. Некоторые службы публично заявили, что начали сканировать сайты под вымышленными именами.

Что делать? Я предлагаю решение, которое гарантированно предотвратит сканирование сайта службами конкурентной разведки. Дополнительный эффект – экономия трафика.

Принцип заключается в проверке робота на точность.

3 — Решение. Как предотвратить сканирование сайта системами конкурентной разведки

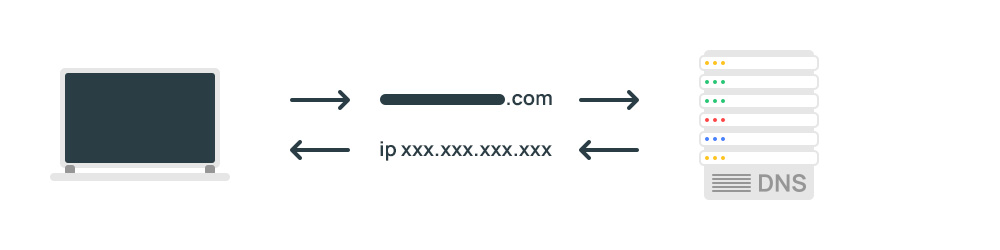

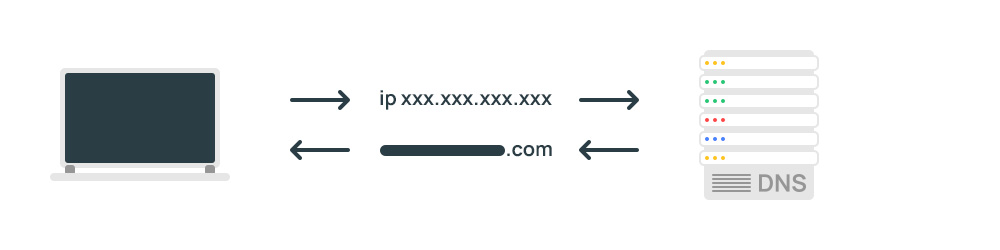

Метод основан на использовании цепочки запросов Сервер доменных имен.

Процедура следующая.

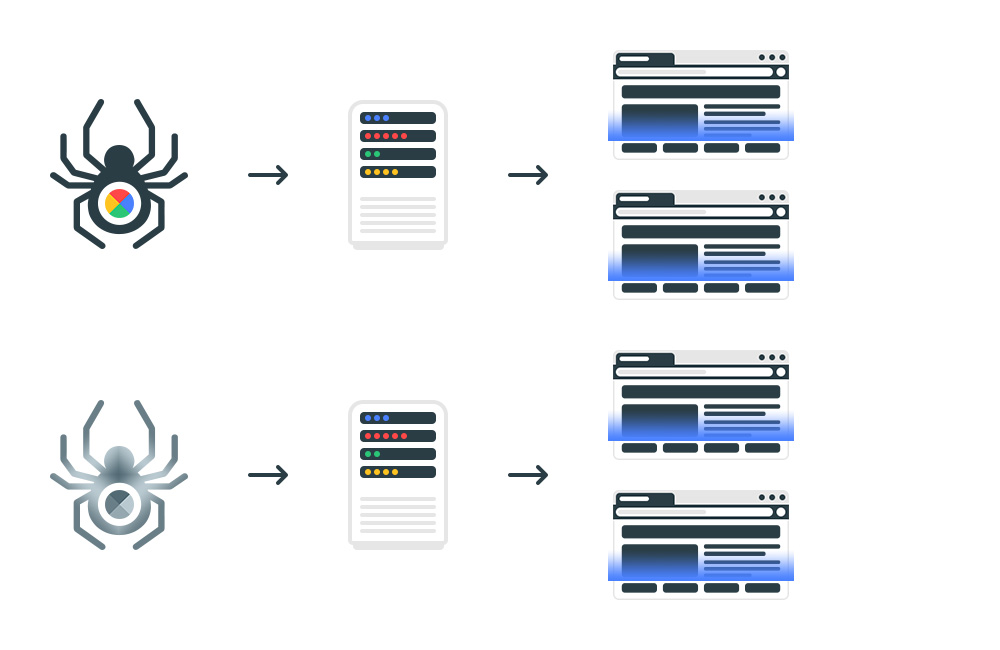

Шаг 1. Робот поисковой системы получает доступ к странице. Указывается в строке запроса. Пользовательский агент для поисковых систем Google и Яндекс. Загрузка IP-адреса.

Шаг 2. Определяем хост по IP-адресу и выполняем обратный DNS-запрос.

Проверяем, принадлежит ли хост Яндексу или Google. Все хосты Googlebots заканчиваются на googlebot.com или google.com. Хосты всех роботов Яндекса заканчиваются на yandex.ru, yandex.net или yandex.com. Если имя хоста имеет другое окончание, робот не принадлежит поисковой системе.

Шаг 3. Выполняем прямой DNS-запрос для перевода хоста на IP. Для этого проводим прямой DNS-запрос. Мы получаем IP-адрес, соответствующий имени хоста.

Шаг 4. Адрес должен совпадать с IP-адресом, используемым при обратном поиске DNS. Если IP-адреса не совпадают, полученное имя хоста подделывается.

В результате запросы конкурентных разведок к сайту были заблокированы. Доступ к сайту открыт для робота поисковой системы.

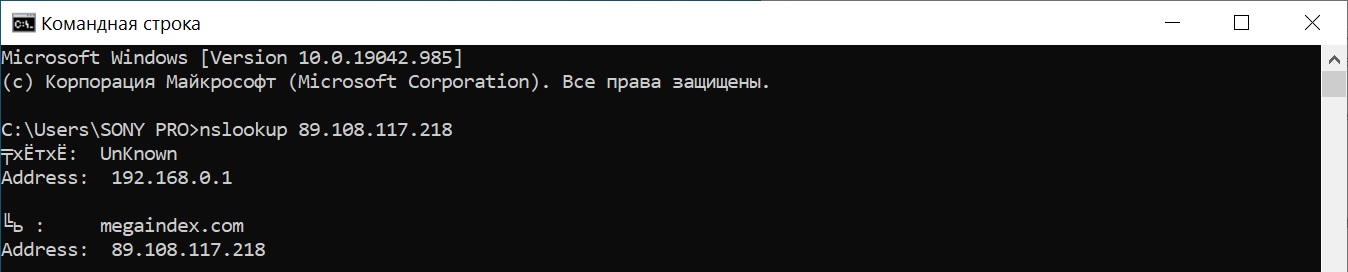

Как выполнить обратный поиск DNS?

Для реализации блокировки необходим скрипт, выполняющий описанный процесс. Методика реализована на всех распространенных языках.

Чтобы понять процесс, я покажу вам, как проверить это самостоятельно.

Например, проверка осуществляется через консоль Windows следующими командами:

Запрос с помощью команды nslookup:

nslookup 89.108.117.218

Результат:

Запрос с Кольцо:

ping -a 89.108.117.218

Выводы

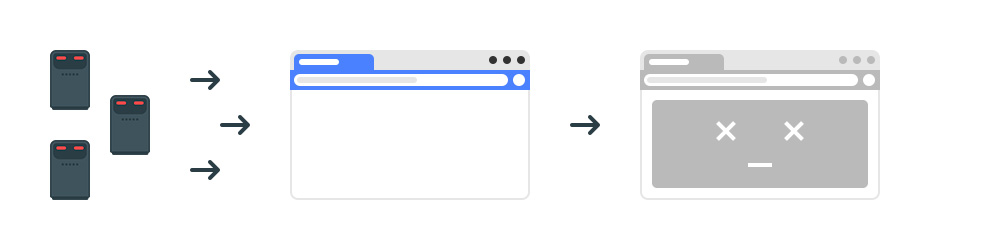

Системы конкурентной разведки и спамеры часто заходят на сайт под видом поисковых роботов.

Системы конкурентной разведки могут помочь вам выявить ценные изменения в рекламе на веб-сайтах.

Данные о проделанной работе по поисковой оптимизации позволяют конкурентам повторить успех.

Рабочий процесс очень прост:

Повторить стратегию поискового лидера легко, поэтому нужно закрыть сайт от систем аналитики.

Есть распространенные простые методы. Например:

- Используйте бан на уровне сервера. Пример кода опубликован на Индексоид;

- Отклонено роботами.

Проблемы следующие:

- Не все роботы выполняют инструкции роботов.

- Вы можете добиться принудительной блокировки с помощью бана на уровне сервера. Однако есть способ обойти защиту. Как? Блокировка осуществляется на основе пользовательского агента. Решением обхода блокировки является подделка переданного значения.

Поисковые системы, в том числе Google и Яндекс, не публикуют списки адресов поисковых роботов.

Как вы можете быть уверены? Это робот поисковой системы сканирует сайт?

Чтобы это проверить, нужно запустить Обратный DNS Расследование.

Если прямой DNS Запрос позволяет получить IP-адрес хоста. Обратный DNS-запрос позволяет получить хост по IP-адресу.

Система проверки с использованием DNS позволяет заблокировать как основной сайт, так и сайты-сателлиты от анализа внешними сервисами.

Алгоритм проверки состоит из следующих шагов:

- Когда робот Googlebot или Яндекс* заходит на сайт, загружаются данные IP.

- Выполните обратный DNS-запрос. Убедитесь, что результатом является доменное имя, принадлежащее поисковой системе. Для Яндекса — yandex.ru, yandex.net или yandex.com. Для Google – googlebot.com или google.com;

- Выполните прямой DNS-запрос, чтобы преобразовать хост в цифровой адрес.

- Проверьте соответствие. IP-адрес должен соответствовать IP-адресу, используемому при обратном поиске DNS. Если IP-адреса не совпадают, это означает, что страницу сканирует не поисковая система, а поддельный хост.

Результат:

- Веб-сайт доступен некоторым роботам поисковых систем.

- Сайт доступен для пользователей.

- Все страницы сайта заблокированы информационными системами.

В результате сервер не передает никакой контент сторонним сервисам. Алгоритм позволяет экономить трафик и защищать сайт от сторонних роботов.

Существует множество настроек DNS. Если вы хотите узнать больше об оптимизации сайта с помощью DNS, пишите в комментариях.

Есть вопросы? Есть ли что-нибудь еще, что можно добавить к материалу? Хотите знать, как отличить робота от пользователя? Напишите сообщение в комментариях.