Наш отчет State of AI Survey показал, что одной из самых больших проблем, с которыми сталкиваются маркетологи при использовании генеративного ИИ, является способность быть предвзятым.

А маркетологи, продавцы и специалисты по обслуживанию клиентов сообщают, что они не решаются использовать инструменты ИИ, потому что иногда они могут давать необъективную информацию.

Понятно, что деловых людей беспокоит предвзятость ИИ, но что вообще делает его предвзятым? В этом посте мы обсудим потенциальный вред от использования ИИ, примеры предвзятости ИИ в реальной жизни и то, как общество может уменьшить возможный вред.

Содержание

Что такое предвзятость ИИ?

Предвзятость ИИ — это идея о том, что алгоритмы машинного обучения могут быть предвзятыми при выполнении запрограммированных задач, таких как анализ данных или создание контента). ИИ, как правило, предубежден таким образом, что увековечивает вредные убеждения, такие как расовые и гендерные стереотипы.

в соответствии с Отчет об индексе искусственного интеллекта за 2023 г., ИИ предвзят, когда он производит результаты, которые усиливают и увековечивают стереотипы, наносящие вред определенным группам. ИИ справедлив, когда он дает прогнозы или результаты, которые не дискриминируют и не отдают предпочтение какой-либо конкретной группе.

Помимо предубеждений и стереотипов, ИИ также может быть предвзятым из-за:

- Выбор образца, где используемые данные не являются репрезентативными для всего населения, поэтому прогнозы и рекомендации нельзя обобщать или применять к опущенным группам.

- Цель, где процесс сбора данных предвзят, в результате чего ИИ делает предвзятые выводы.

Как предвзятость ИИ отражает предвзятость общества?

ИИ предвзят, потому что общество предвзято.

Поскольку общество предвзято, большая часть данных содержит ИИ, обученный на предубеждениях и предрассудках общества, поэтому он изучает эти предубеждения и выдает результаты, которые их закрепляют. Например, генератор изображений, которого попросили создать изображение генерального директора, может создать изображения белых мужчин из-за исторической предвзятости по безработице в данных, на которых он учился.

По мере того, как ИИ становится все более распространенным явлением, многие опасаются, что он может масштабировать уже существующие в обществе предубеждения, которые наносят вред многим различным группам людей.

Примеры смещения ИИ

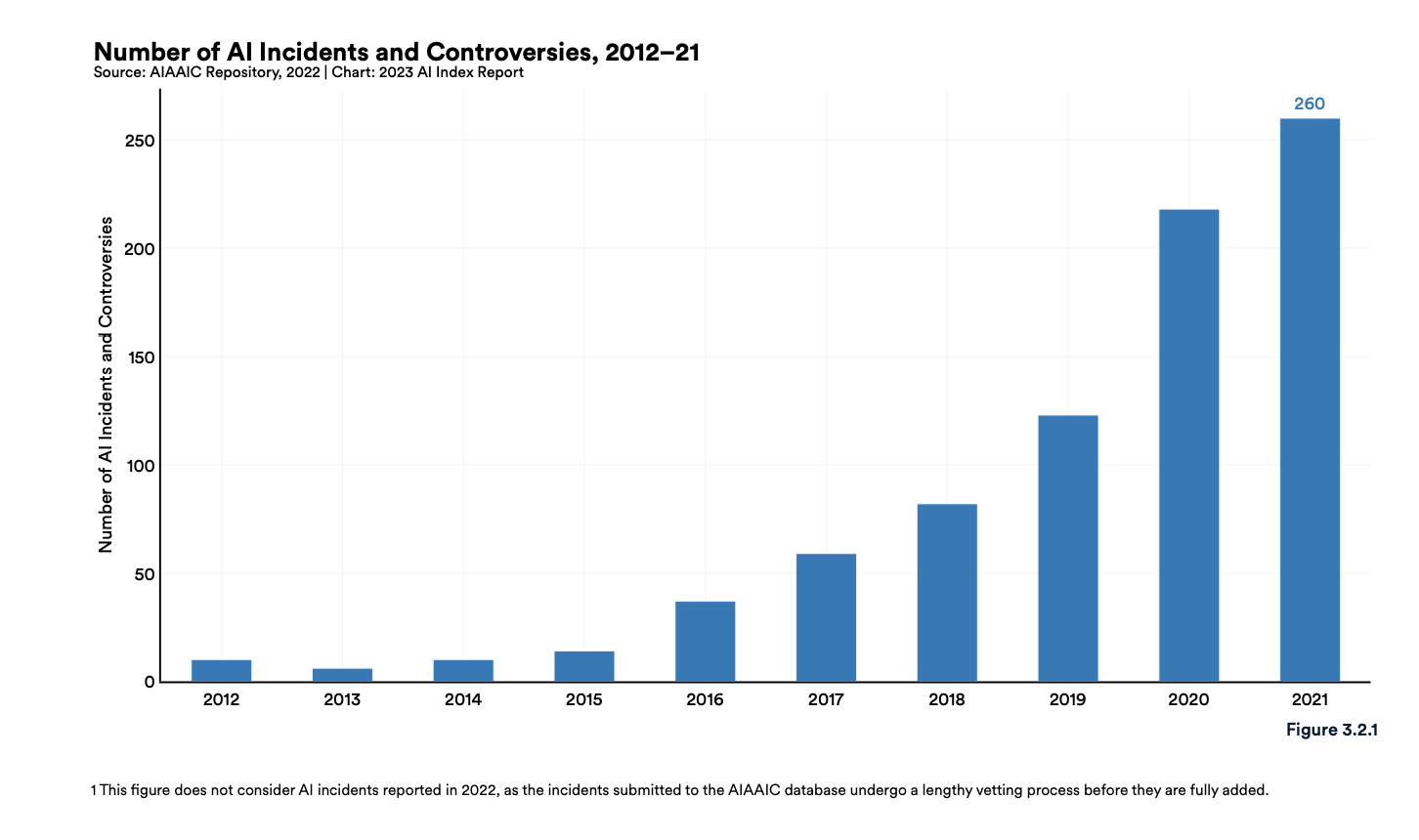

Репозиторий разногласий по инцидентам в области искусственного интеллекта, алгоритмов и автоматизации (АИААИК) утверждает, что количество новых инцидентов и разногласий, связанных с ИИ, в 2021 году было в 26 раз больше, чем в 2012 году.

Давайте рассмотрим несколько примеров предвзятости ИИ.

Показатели одобрения ипотечных кредитов являются хорошим примером предубеждение в ИИ. Алгоритмы оказались 40-80% с большей вероятностью откажут цветным заемщикам, потому что исторические данные о кредитовании непропорционально показывают, что меньшинствам отказывают в кредитах и других финансовых возможностях. Исторические данные учат ИИ предвзято относиться к каждому будущему приложению, которое он получает.

Существует также потенциал для систематическая ошибка размера выборки в медицинских областях. Допустим, врач использует искусственный интеллект для анализа данных пациента, выявления закономерностей и составления рекомендаций по уходу. Если этот врач в основном принимает белых пациентов, рекомендации не основаны на репрезентативной выборке населения и могут не учитывать уникальные медицинские потребности каждого.

В некоторых компаниях есть алгоритмы, которые приводят к фактически предвзятым решениям или делают их потенциал более заметным.

1. Алгоритм рекрутинга Amazon

Amazon построила алгоритм рекрутинга, обученный десятилетнему опыту найма. Данные отражали преобладание мужчин в рабочей силе, поэтому алгоритм научился предвзято относиться к заявкам и наказывать резюме от женщин или любые резюме, в которых используется слово «женщины».

2. Обрезка изображения в Твиттере

ОДИН вирусный твит в 2020 году показали, что алгоритм Twitter отдавал предпочтение белым лицам, а не черным, при обрезке изображений. Белый пользователь неоднократно делился фотографиями со своим лицом, лицом чернокожего коллеги и другими чернокожими лицами на одной и той же фотографии, и она постоянно обрезалась, чтобы показать его лицо в превью.

Twitter признал предвзятость алгоритма и сказал: «Хотя наши анализы на сегодняшний день не показали расовой или гендерной предвзятости, мы признаем, что то, как мы автоматически обрезаем изображения, означает, что существует потенциальный вред. Мы должны были лучше предвидеть эту возможность, когда впервые проектировали и создавали этот продукт».

3. Расистское распознавание лиц робота

Недавно исследователи провел исследование просит роботов сканировать лица людей и классифицировать их по разным ящикам в зависимости от их характеристик, причем три ящика — это врачи, преступники и домохозяйки.

Робот был пристрастен в этом процессе, чаще всего идентифицируя женщин как домохозяек, чернокожих мужчин как преступников, латиноамериканских мужчин как уборщиков, а женщин всех национальностей с меньшей вероятностью выбирали врачами.

4. Программное обеспечение для мониторинга Intel и Classroom Technology

Программное обеспечение Class от Intel и Classroom Technology имеет функцию, которая отслеживает лица учащихся, чтобы определять эмоции во время обучения. Многие ссылались на различные культурные нормы выражения эмоций как на высокую вероятность того, что эмоции учащихся будут неправильно обозначены.

Если учителя используют эти ярлыки, чтобы говорить с учащимися об уровне их усилий и понимания, учащиеся могут быть наказаны за эмоции, которые они на самом деле не проявляют.

Что можно сделать, чтобы исправить предвзятость ИИ?

Этика ИИ — горячая тема. Это понятно, потому что предвзятость ИИ была продемонстрирована в реальной жизни разными способами.

Помимо предвзятости, ИИ может распространять вредоносную дезинформацию, такую как дипфейки, а генеративные инструменты ИИ могут даже давать фактически неверную информацию.

Что можно сделать, чтобы лучше понять ИИ и уменьшить потенциальную предвзятость?

- Контроль человека: Люди могут отслеживать результаты, анализировать данные и вносить исправления при появлении предвзятости. Например, маркетологи могут уделять особое внимание генеративным выводам ИИ, прежде чем использовать их в маркетинговых материалах, чтобы убедиться, что они справедливы.

- Учитывайте возможность предвзятости: Некоторые варианты использования ИИ могут нанести ущерб конкретным сообществам. В этом случае люди могут не торопиться, чтобы рассмотреть вероятность того, что их ИИ даст предвзятые результаты, например, банковские учреждения, использующие исторически предвзятые данные.

- Инвестиции в этику ИИ: Один из наиболее важных способов уменьшить предвзятость ИИ — это постоянные инвестиции в исследования ИИ и этику ИИ, чтобы люди могли разработать конкретные стратегии для ее уменьшения.

- Диверсификация ИИ: Наличие разных точек зрения на ИИ помогает создавать объективные практики, когда люди привносят свой собственный жизненный опыт. Разнообразное и репрезентативное поле дает людям больше возможностей распознать возможность предвзятости и устранить ее до того, как будет причинен вред.

- Признать предвзятость человека: У всех людей есть потенциал для предвзятости, либо из-за разницы в жизненном опыте, либо из-за предвзятости подтверждения во время исследования. Люди, использующие ИИ, могут признать свои предубеждения, чтобы гарантировать, что их ИИ не будет предвзятым, как исследователи, проверяющие репрезентативность размеров своей выборки.

- Быть прозрачным: Прозрачность всегда важна, особенно с новыми технологиями. Люди могут завоевать доверие и понимание с помощью ИИ, просто сообщив об этом, когда они используют ИИ, например, добавив примечание под новостной статьей, созданной ИИ.

Ответственно использовать ИИ вполне возможно.

ИИ и интерес к ИИ только растут, поэтому лучший способ оставаться в курсе потенциального вреда — это быть в курсе того, как он может увековечить вредные предрассудки, и принять меры, чтобы использование ИИ не подлило масла в огонь. .

Хотите узнать больше об искусственном интеллекте? Проверь это путь обучения.